作者简介: 吴念倚,女, 2000年生,石河子大学信息科学与技术学院硕士研究生 e-mail: wunianyi11@gmail.com

黄萎病对棉花产量和质量构成严重威胁。 快速、 准确地检测黄萎病严重程度是棉花黄萎病(CVW)控制的基础。 现有的CVW检测主要集中在图像或光谱级别, 忽略了特征融合的重要性, 这限制了模型的性能。 为解决此问题, 提出了一种CVW等级检测方法图谱特征融合模型(SSFNet)。 首先, 选择对受感染植物像素变化敏感的LAB颜色空间进行数据增强, 以丰富RGB图像的特征表示, 并使用改进的ResNet网络构建图像特征提取模块。 此外, 还构建了光谱特征提取模块, 并比较最小绝对收缩和选择算子(LASSO)以及主成分分析(PCA)算法选取的特征波段与全光谱之间的差异。 最后, 基于图像和光谱级别的探索构建了特征融合模型SSFNet。 实验结果显示, 相较于用单一数据类型特征进行检测, 图谱特征融合方法SSFNet效果最好, F1分数达到了95.96%, 展现了图谱特征融合方法与深度学习技术结合在CVW等级检测中的潜力。

Verticillium wilt poses a severe threat to cotton yield and quality. Rapid and accurate detection of Verticillium wilt is essential for controlling cotton Verticillium wilt (CVW). Existing CVW detection methods mainly focus on the image or spectral level, overlooking the importance of feature fusion, which limits model performance. We propose a CVW grade detection method, spatial-spectral Fusion Network (SSFNet), to address this. First, we enhance the LAB color space, which is sensitive to pixel changes in infected plants, to enrich the feature representation of RGB images and use an improved ResNet network to build an image feature extraction module. Next, we construct a spectral feature extraction module based on the improved ResNet network and compare the performance of two common feature extraction methods: Least Absolute Shrinkage and Selection Operator (LASSO) and Principal Component Analysis (PCA). Finally, we build the feature fusion model SSFNet based on image and spectral level exploration. Experimental results show that SSFNet performs best compared to single data type features, with an F1 score of 95.96%, demonstrating the potential of image-spectral feature fusion methods combined with deep learning for CVW grade detection.

棉花是全球重要的经济作物, 但黄萎病对其生长造成严重威胁[1]。 黄萎病通过感染棉花根部, 引起叶片萎蔫、 变色和脱落, 导致棉花品质和产量大幅下降[2]。 因此, 监测和防治棉花黄萎病(cotton verticillium wilt, CVW)备受关注。 目前, CVW严重程度判断是由专家目视检查或测量棉株中大丽轮枝菌的生物量来定量检测, 成本高且效率低[3]。 随着计算机技术的进步, 支持向量机和极限学习机等机器学习方法被用来检测CVW危害程度[4, 5], 但此方法依赖人工特征提取, 泛化能力差。 为克服传统方法的局限, 许多学者利用深度学习强大的特征提取能力来检测CVW严重程度[6, 7, 8]。

通过深度学习检测植物病害图像是关键的研究方向之一, 它可以识别传统图像处理方法无法检测到的植物细微变化。 Zhang等[9]利用卷积神经网络(convolutional neural networks, CNN)成功提高了番茄叶片病的识别率。 Liang等[10]使用改进CNN成功提取水稻白叶枯病特征, 实现了高效识别。 为使模型更关注关键特征, 有学者将注意力机制与深度学习结合, 如Nawaz等[11]采用ResNet34和注意机制构建CNN, 实现了番茄叶病的高精度检测。 Cheng等[12]提出了一种同时考虑空间信息和通道信息的注意机制, 将其与MobileNetV3集成, 在苹果叶病的检测方面取得了良好效果。 这些研究虽然有效, 但只关注图像特征, 忽略了植物感染后内部生理变化。

高光谱检测方法能反映受感染植物的内部生理变化, 是基于深度学习的植物病害检测的另一个重要的方向。 Feng等[13]和Jin等[14]结合高光谱技术和深度学习技术, 成功地识别了水稻和小麦的病害。 Yadav等[15]通过主成分分析算法(principal component analysis, PCA)对柑橘病害光谱数据的维度降维来训练CNN模型, 效果显著。 这些研究表明, 高光谱技术与深度学习相结合能有效地实现植物病害检测。 对于模型性能提升来说, 丰富的数据类型很重要。 不同类型数据的融合有互补作用[16]。 在深度学习中, 可以通过数据转换来融合不同的数据类型, 提高模型性能的同时还能弥补不同数据类型的异构性差异。 然而, 目前CVW检测的研究大多集中在单一数据类型[5, 17], 忽略了图谱融合的重要性。 因此, 本研究开发了一个融合棉花图像空间特征和光谱特征的模型(spatial-spectral feature fusion Network, SSFNet), 以准确检测CVW严重程度。 工作流程如图1所示。 具体内容如下:

(1)在图像方面, 探索了基于注意机制的2DResNet方法。 利用LAB颜色空间的特征补充RGB颜色空间特征。 通过残差网络结构和跳跃连接, 保证梯度有效传播, 并结合高效通道注力机制(efficient channel attention, ECA)[18]增强对受染棉株图像关键区域的关注。

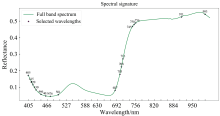

(2)在光谱方面, 研究了一种基于残差网络(1DResNet)和非局部注意力机制(non-local attention, Nonlocal)[19]的方法, 捕获受染棉株光谱数据的长距离依赖关系, 并比较了最小绝对收缩和选择算子(least absolute shrinkage and selection operator, LASSO)和PCA两种特征提取方法与全谱输入的性能差异。

(3)结合改进后的2DResNet和1DResNet结构, 开发融合模型SSFNet, 有效融合图谱特征, 实现对CVW等级的准确检测。

选取新陆早1号(易感病)和新陆早76号(抗病性)两个棉花品种进行实验。 样品在新疆石河子市石河子大学农学院温室中培养(86° 3'34″E, 44° 18'58″N)。 2023年3月用水培法培养棉花, 待根长超过10 cm将植株移至育苗盒中垂直生长。 棉花长至两片叶时, 移至透明培养瓶, 方便后续实验。 2023年5月, 棉花生长至五叶阶段, 从每个品种中选择80株作为健康对照组, 另80株接种病原菌。 据专家建议, 将棉苗根部浸泡在浓度为1× 107 CFU· mL-1的大丽轮枝菌溶液中1 h, 确保接种有效。 从接种后第二天起, 连续收集CVW高光谱图像。 样品展示如图2。

1.1.1 高光谱数据采集, 预处理及数据集划分

利用可见光-近红外高光谱成像系统对棉花样品进行图像数据采集。 设备包括美国加州圣地亚哥SOC公司的710-VP相机和HyperScaner-VP采集软件, 系统光谱范围为376~1 044 nm, 覆盖128个波段, 曝光时间为24 ms, 光谱分辨率为5 nm。 实验在暗箱内进行, 以避免环境照明的影响, 由四个50 W卤素灯均匀照明。 成像系统分辨率为520× 696像素, 整棵棉株作为感兴趣区域(region of interest, ROI)单独成像。 由于相机的暗电流和光强变化, 需对原始图像进行黑白校准以减轻噪声干扰, 校正公式如式(1)。

式(1)中, I是矫正后的图像, Io-d为原始高光谱图像数据减去反射率为0的暗反射率图像数据, Iw-d是反射率为100%的白色反射率图像数据减去原始高光谱图像数据。

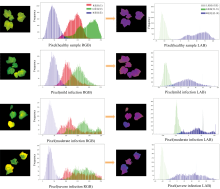

由于棉株的原始高光谱图像中存在背景噪声干扰, 影响平均光谱反射率提取, 必须进行背景去除。 选择747~853 nm的高光谱图像, 使用OTSU算法创建去除背景信息的掩模, 然后通过计算ROI的平均谱代表棉株的光谱。 采用平滑滤波器[20](Savitzky-Golay, SG)提高初始平均光谱数据的平滑性, 减轻噪声。 使用ENVI 5.3处理光谱数据, 决定合成RGB图像的波段信息是从SOC公司提供的软件中获取的, 分别为代表红、 绿、 蓝波长的 698、 548和 461 nm, 涵盖了可见光范围内的关键光谱信息。 然后用颜色空间转换算法将图像从RGB转换为LAB颜色空间, 以进行更深入的颜色分析和处理。 提取过程如图3所示。

共采集847幅棉株高光谱图像, 并按国家标准GB/T 22101分为4个等级: 0级(健康、 无症状)、 1级(症状小于25%, 有淡黄色病变)、 2级(26%~50%叶片有症状, 病变为黄色或褐色)和3级(超过50%的叶片有症状, 边缘轻微卷曲或萎蔫)。 数据集按3∶ 1∶ 1的比例划分为训练、 验证和测试集, 数据数量和划分结果如表1。

| 表1 黄萎病数据集划分 Table 1 The division of CVW data set |

1.2方法

1.2.1 图像颜色空间增强方法

受感染棉叶颜色会从绿色渐变为病态的黄色。 由于RGB颜色空间对细微颜色变化不够敏感, 可能忽略关键特征, 因此本研究采用对颜色变化高度敏感的LAB颜色空间[21]特征来补充RGB颜色空间的特征。 为确保转换准确, 需先将RGB颜色空间转换为标准参考模型XYZ颜色空间。 具体步骤如下: 首先将RGB值中的每个通道值除以255进行规范化, 然后对每个通道值应用逆伽马校正以线性化颜色响应, 最后使用特定的变换矩阵[21]将逆伽马矫正后的RGB值相乘, 计算出XYZ颜色空间的值, 如式(2)所示, 其中g(x)是逆伽马函数。

完成XYZ颜色空间的转换后, 使用XYZ颜色空间来转换LAB颜色空间。 图4展示了转换后的RGB和LAB色度空间图像及其对应的像素分布直方图。 从图中可以看出, 与RGB颜色空间依赖红、 绿、 蓝三色通道共同构成图像不同, LAB色彩空间将亮度信息(L通道)与色彩信息(A和B通道)分离开来, 使得在分析不同疾病等级时可以更精确地捕捉颜色变化。 LAB色度空间中的转换公式如式(3)— 式(5)所示

式(3)— 式(5)中, Xn, Yn和Zn的值均为参考白点的坐标值, 分别为95.047、 100.000和108.883, 用于校正和保持颜色的一致性。 式中的f(x)是转换函数, 用于处理颜色空间中的亮度和颜色差异。 具体如式(6)所示。

1.2.2 光谱降维方法

由于棉株的高光谱图像包含大量的信息, 存在冗余和高计算开销的风险。 合理的降维处理有助于消除冗余信息, 提高计算效率。 因此, 探讨了两种主要的特征降维方法: LASSO和PCA, 并比较它们在CVW严重程度检测中所选择的光谱带作为特征输入时的表现。

LASSO算法通过对回归系数施加L1惩罚, 并将不重要的特征系数压缩为零来选择特征波长。 这个过程可以用式(7)来描述, 该算法选择的重要波段如图5所示。

| 图5 LASSO算法选择的波段示意图 绿线表示光谱反射率, 所选波段在图中用紫色星号标记Fig.5 Schematic of LASSO-selected bands The green line represents the spectral reflectance, and the selected bands are marked with a purple asterisk |

$\text { LASSO }=\frac{1}{2 N} \sum_{i=1}^{N}\left(y_{i}-\sum^{M j=1} X_{i j} \beta_{j}\right)^{2}+\lambda \sum_{j=1}^{M}\left|\beta_{j}\right|$(7)

式(7)中, β j为回归系数, 通过目标函数最小化的方法确定。 N和M分别表示样本总数和波长总数。 对于每个样本i, Xij表示其在第j个波长处的光谱值, yi表示样本的疾病严重程度。 正则化参数λ 控制L1惩罚强度, 取值在0和1之间。

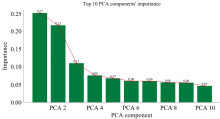

PCA算法通过线性变换将高维数据投影到低维空间, 降低数据维度和复杂度。 该转换方式旨在查找数据中最大方差的方向, 以保留尽可能多的信息。 选择包含原始数据95%信息的前四个主成分来实验, 如图6所示。

1.2.3 基于注意机制的关键特征提取

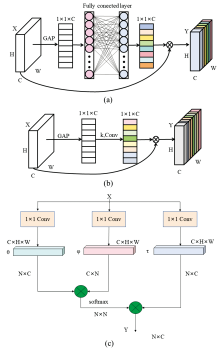

近年来, 由于注意力机制能够使得深度学习网络关注输入数据的关键部分并优化特征处理而被广泛使用[22, 23]。 探索了适用于挖掘CVW图像数据和光谱数据关键特征的注意机制, 比较了主流的三种: 挤压和激励(squeezeand excitation, SE)[24], ECA和Nonlocal机制。 这些机制各有优势, SE机制通过增强特征通道之间的交互作用来提高特征表达能力, ECA机制能有效地优化通道注意力分配, Nonlocal能增强对特征全局依赖的捕获来提高性能。 SE机制[图7(a)]通过全局平均池化(global average pooling, GAP)来细化通道级的全局信息, 并加权通道的重要性。 最后, 通过全连接层连同ReLU和Sigmoid激活函数确定各通道的权重。

ECA机制[图7(b)]是从SE注意力机制进化而来, 采用更有效的一维卷积而不是全连接层来映射通道间的相互依赖。 ECA的计算过程用式(8)所示

式(8)中, σ 为Sigmoid函数, Conv1k是一维卷积操作, 其卷积核的大小k是通过通道维度C自适应确定的。 G(X)是对X进行全局平均池化。 在式中, 若式(8)中的一维卷积被全连接层取代, 就是SE的计算方式。

与ECA和SE更局部的注意力焦点形成对比, Nonlocal机制[图7(c)]通过捕获数据内部长距离的依赖关系来增强特征的全局表示。 通过计算特征图内所有位置之间的响应来实现全局上下文的捕获, 从而帮助模型利用图像或光谱数据中分布广泛的、 相关性高的特征。 计算公式如式(9)

式(9)中, X和Y分别代表输入序列, 和对应的输出序列。 i和j表示不同的特征位置。 h[θ (Xi), ϕ (Xj)]计算位置i和j之间的相似度函数, θ 和ϕ 是两个不同的1× 1卷积操作。 τ (Xj)计算X在j处的表示, C(X)是归一化函数, 用来确保输出序列Y的尺度不变。

1.2.4 图谱特征融合模型的总体架构

提出了一种图谱特征融合模型SSFNet, 区别于现有检测CVW严重程度的融合策略[4], SSFNet加强了特征的全局依赖性, 能深入挖掘特征信息, 避免繁琐的手工提取特征。 图8显示了其整体结构: 图像分支处理图像数据, 包含8个降采样的残差模块, 每个模块包含一个残差结构和ECA机制。 这些模块通过合适的步长卷积减少输入特征图的空间尺寸, 增加特征图的深度, 防止梯度消失, 并提高识别关键特征的能力。

光谱分支由四个一维残差模块和两个下采样一维残差模块组成, 引入的Nonlocal机制增强了对光谱数据中长距离特征依赖关系的捕获。 一维残差模块通过直接传输机制保持数据的完整性, 减少信息丢失, 降采样残差模块通过调整步长降低特征维度和计算负担, 提高模型检测复杂数据结构下细微特征变化的能力。 两个分支的输出特征在模型末端通过特征拼接进行融合, 再经过全连接层处理, 输出最终的分类决策。

使用配备NVIDIA GeForce RTX3090 GPU的机器和pytorch框架, 虚拟环境通过Anaconda3构建。 选用Adam优化器, 初始学习速率为0.001, 并加入L2正则项防止过拟合。 采用交叉熵损失函数, 并使用ReduceLROnPlateau调度器优化性能, 其衰减因子为0.5, 容忍次数为10。 批量大小设为32, 训练共200个epoch。 模型性能通过准确率(accuracy)、 精确率(precision)、 召回率(recall)和F1分数(F1 score)进行评价。

比较了四种经典深度学习架构在CVW病害等级检测的性能: DenseNet2D[25], MobileNet2D[26], EfficientNet2D[27]和 ResNet2D[28], 并探讨了不同颜色空间(RGB、 LAB、 RGB+LAB)对模型性能的影响。 表2中的实验数据显示, ResNet2D在RGB颜色空间中准确率最高(89.11%), 但在LAB颜色空间中降至78.17%。 然而, 在结合两个颜色空间后, ResNet2D的准确率跃升至90.15%, 显示出颜色空间特征融合能显著提高模型性能。 相比之下, EfficientNet2D在单一颜色空间表现良好, 但在颜色空间融合后准确率有所下降。 DenseNet2D在所有测试的颜色空间中表现均不理想。 MobileNet2D则在颜色空间融合后显示出较好的适应性和准确性提升, 但效果不如ResNet2D。 总之, ResNet2D结合颜色空间特征融合方法在提高CVW图像等级检测任务准确性方面具有潜力。 进一步对SE、 ECA和Nonlocal注意力机制加入ResNet2D对性能的影响进行探索。 表3结果显示, 引入ECA机制使模型性能提高了约2%, 表明ECA机制能有效增强模型在CVW等级检测任务中的表现。

| 表2 不同网络模型在不同颜色空间下的性能比较 Table 2 Comparison of model performance of different network models in different colour spaces |

| 表3 ResNet2D中添加不同注意力机制的对比表 Table 3 Comparison table of ResNet2D adding different attention mechanisms |

在最佳ECA机制与ResNet2D组合框架内, 采用梯度加权类激活映射(gradient-weighted class activation mapping, Grad-CAM)技术对关键决策区域进行可视化。 图9的B行显示了RGB颜色空间中的Grad-CAM结果, 网络关注区域的热图[图9(e)— (h)]揭示了模型的关注点。 颜色越深, 关注度越高。 在健康棉株中[图9(e)], 模型主要关注整个叶片及其纹理, 而在病害状态下[图9(f)— (h)], 关注点逐渐转移到变黄和受感染区域。

| 图9 网络中感兴趣区域的可视化图像(ResNet2D+ECA)Fig.9 Visualization images of areas of interest in the network(ResNet2D+ECA) |

LAB颜色空间中的图像[图9(i)— (l)]及其对应的热图[图9(m)— (p)]显示不同的网络关注水平, 差异用红色圆圈标记。 特别是在轻度到重度受感染的棉花例子中[图9(n)— (p)], 当叶片颜色变化时, 模型的关注度更高, 热图的深橙色区域尤为明显。 结合图像特征融合的优异结果, 这表明LAB颜色空间下的特征有效补充了RGB颜色空间下的特征, 帮助网络从不同角度理解和分析图像, 从而提高分类的准确性。

为了探索适合CVW光谱特征提取的网络, 使用DenseNet1D、 MobileNet1D、 EfficientNet1D和ResNet1D处理全光谱特征、 PCA降维后的特征以及由LASSO算法选择的关键特征, 并评估分类效果。 结果如表4所示, ResNet1D在各种数据类型上识别准确率均较高, 显示其残差结构有效捕捉了CVW光谱数据的重要特征。 然而, 使用PCA降维后的特征导致性能下降, 可能因为降维过程中丢失了关键信息。 此外, 使用LASSO算法选择的特征时, 所有模型的性能指标均下降到70%以下, 可能是由于选取的特征与CNN模型利用的特征不匹配。 总之, 使用全光谱的ResNet1D在检测CVW等级上表现更佳。

| 表4 使用不同光谱特征类型作为输入时深度学习模型结果的比较表 Table 4 Comparison of results obtained from deep learning models using different types of spectral features as input |

ResNet1D加入不同注意力机制后的模型性能如表5所示, 可见, 以加入Nonlocal注意力机制的模型表现最优, 准确率从85.54%提升到87.21%。

| 表5 ResNet1D中添加不同注意力机制的对比 Table 5 Comparison of ResNet1D adding different attention mechanisms |

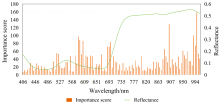

为了深入了解ResNet1D结合Nonlocal机制在网络模型决策过程中主要关注的特征, 利用显著性图进行了可视化分析。 如图10所示, 柱状图的高度表示网络对不同波段的关注度, 绿色曲线代表反射率。 可以观察到网络主要聚焦于580~610、 690~700、 900~920以及980~1 000 nm。 其中, 580~610 nm(黄橙光区域)和690~700 nm(红边区域)的光谱反射率主要反映植株的叶绿素吸收和生理状态。 感染会导致叶绿素含量减少和光合作用减弱, 因此这些波段对检测感染很重要。 此外, 由于黄萎病会破坏棉花的根系组织, 影响水分和营养物质的吸收与转运, 进而导致植株内部水分减少和细胞活性下降, 因此900~920和980~1 000 nm这两个波段的关注显示了网络对植物生理变化的敏感性。 对这些区域的关注使得模型能够更准确地检测CVW严重程度。

在对图、 谱数据探索的基础上, 进一步设计了SSFNet。 该模型集成两种高性能结构: 一是ResNet+ECA结构, 它在处理图像信息方面表现最好; 二是ResNet+Nonlocal结构, 它在处理光谱信息方面表现最好。 最后, 利用特征拼接方法对提取的特征进行融合。 对比了加入不同注意力机制的模型的性能, 如表6所示。

| 表6 模型性能对比 Table 6 Model performance comparison |

可见SSFNet显著提高了分类效果。 单独使用RGB和LAB颜色空间特征或光谱特征的表现不及这些特征组合后, 显示了融合不同类型特性的优势。

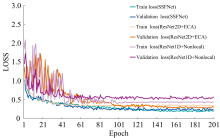

基于光谱数据的ResNet1D, 基于图像数据的ResNet2D和基于特征融合的SSFNet模型的训练损失曲线如图11所示。 各模型的损失随着训练周期增加而下降, 其中ResNet2D和ResNet1D的损失震荡明显, 而SSFNet模型显示出更快的收敛速度和较小的损失震荡。 这表明特征融合后, 丰富的特征类型加快了模型训练的收敛速度。 总之, SSFNet实现了更短的训练周期和更高的预测精度。

基于ResNet1D和ResNet2D开发了SSFNet模型, 专门用于检测CVW的等级。 ResNet1D和ResNet2D分别处理光谱数据和图像数据, 通过特征拼接与融合模块有效地结合这两种数据类型的特征。 实验结果显示, 融合后的模型表现优异, F1分数达到了95.96%。

研究结果显示, 融合图像与光谱特征能显著增强模型的检测性能。 然而, 不同数据类型之间的固有差异对特征提取的效率构成了一定限制, 需要进一步研究。 深度学习技术的进步提供了良好的技术支持。 为不同数据类型设计特定的CNN架构, 可以更高效地提取和融合不同类型的特征。 SSFNet促进了光谱数据的降维和有效特征提取, 确保了有效特征提取并与图像数据融合, 实现精确的CVW等级检测。 避免了处理光谱数据的复杂手动特征提取和模型计算压力, 同时也解决了关键特征被忽略的问题。

SSFNet弥补了单一数据类型的局限, 提高了模型的检测能力。 然而, 本研究使用的数据集相对单一, 无法检测处于不同生长阶段的CVW, 这可能会影响模型的泛化能力。 未来将侧重获取更多棉花生长阶段的CVW数据。 此外, 目前的研究主要在温室环境中进行, 计划将研究扩展到田间条件, 以更好地评估模型的实际应用。

CVW的发展严重影响棉花产量和质量。 本研究通过融合受感染棉株的图像和光谱数据, 实现了有效的特征融合和CVW分级。 结果表明, 在图像中, ResNet和ECA结合的模型在使用双色空间特征时表现最佳; 在光谱数据中, 结合ResNet和Nonlocal的方法效果最佳。 最后, SSFNet的双分支结构通过合并图谱数据, 提高了检测精度, 优于使用单一数据类型的方法。 这种方法不仅提高了CVW等级检测精度, 还可以扩展到其他农业领域的应用。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|