作者简介: 张 倩,女, 1996年生,中国农业大学信息与电气工程学院硕士研究生 e-mail: 1575430884@qq.com

乳腺炎是奶牛生产养殖中最为严重的疾病之一, 奶牛乳腺炎的早期检测可以为后续治疗提供依据, 从而提高疾病治疗效率, 降低养殖风险。 为了对自然行走的奶牛实现快速、 高精度的“一步式”乳腺炎疾病检测, 提出了一种基于热红外图像, 融合数据增强与改进ResNet34的奶牛乳腺炎疾病检测方法。 相对于现有的“多步式”奶牛红外图像乳腺炎检测方法, 该方法无需奶牛关键部分如乳房和眼睛的定位以及温度提取等, 可有效避免“多步式”造成的误差累计, 从而实现更高效的乳腺炎检测。 首先, 将包含奶牛关键部位的局部图片水平拼接成信息完整的整体图片, 结合RandAugment数据增强方法扩增训练样本; 其次, 采用ResNet34残差网络作为实验的基础网络, 并根据热红外图像特性对模型进行如下改进: (1)精简网络内部冗余层使得模型更轻量化; (2)中间层添加辅助分类器弥补由于模型精简带来的特征损失; (3)将改进的多融合池化层代替原有单一池化层, 使得特征提取内容更丰富。 随机选取3 298张热红外图像(66头奶牛)作为实验对象, 并设置多组对比实验, 结果表明: 与传统ResNet34相比改进后ResNet34模型分类准确率提高3.4%, 基于改进ResNet34并融合迁移学习和数据增强的模型验证准确率达到90.3%, 测试准确率为88.4%, 分类时间仅需3.39×10-3 s。 为了保证实验数据集的样本独立性, 进一步将奶牛个体数量按照3:1:1划分为训练集、 验证集和测试集, 测得模型测试准确率达到80.3%, 证明所提出模型具有很好的鲁棒性。 根据测试结果, 计算出模型查准率为91.2%、 查全率为91.6%、 F1分数为91.4%, 与前人所做实验相比准确率提高了5.1%, 特异度提升5.3%。 该研究方法可以为初期奶牛乳腺疾病筛选和医学诊断提供辅助和参考。

Mastitis is one of the most serious diseases in dairy production and breeding. The early detection of cow mastitis can provide the basis for follow-up treatment to improve the efficiency of disease treatment and reduce the risk of breeding. In order to realize fast and high-precision “one-step” mastitis disease detection for naturally walking dairy cows, a dairy cow mastitis disease detection method based on the thermal infrared image, data enhancement and improved ResNet34 is proposed in this paper. Compared with the existing “multi-step” dairy cow infrared image mastitis detection method, this method does not need the positioning of key parts of dairy cows, such as breast and eyes and temperature extraction, which can effectively avoid the error accumulation caused by “multi-step”, to achieve more efficient mastitis detection. Firstly, this method horizontally splices the local pictures containing the key parts of the cow into an overall picture with complete information and expands the training samples combined with the RandAugment data enhancement method; Secondly, the ResNet34 residual network is used as the basic network of the experiment, and the model is improved as follows according to the characteristics of thermal infrared image: (1) simplify the redundant internal layer of the network to make the model lighter; (2) Auxiliary classifiersare added in the middle layer to make up for the feature loss caused by model simplification; (3) The improved multi fusion pool layer is used to replace the original single pool layer, which makes the content of feature extraction richer. Finally, 3 298 thermal infrared images (66 cows) were randomly selected as the experimental objects, and multiple groups of comparative experiments were set. The results showed that compared with the traditional ResNet34, the classification accuracy of the improved ResNet34 model was improved by 3.4%, the model verification accuracy based on the improved ResNet34 combined with transfer learning and data enhancement was 90.3%, the test accuracy was 88.4%, and the classification time was only 3.39×10-3 seconds. In addition, to ensure theindependence of the experimental data set, this paper further divides it into the training set, verification set and test set according to the number of dairy cows in 3:1:1. The test accuracy of the model was 80.3%, which proves that the proposed model has good robustness. According to the test results, it is calculated that the precision rate, recall rate and F1 score of the model are 91.2%, 91.6% and 91.4%. Compared with previous experiments, the accuracy is improved by 5.1% and the specificity is improved by 5.3%. In conclusion, this research method can provide a reference for screening and medical diagnosis of breast diseases in early dairy cows.

随着人民生活水平的提高, 人们更加重视食物的营养健康, 牛奶中含有丰富的乳蛋白和维生素, 日常饮用牛奶有益于提高人体的免疫力。 据《中国奶业统计资料》显示: 2020年全国牛奶产量为3 440万吨, 占比全球总产量的5%, 奶牛养殖规模比例达到67%[1]。 发展奶牛养殖业对于国家的畜牧业发展和农业农村经济发展都有极其重要的作用[2]。 奶牛乳房炎是奶牛生产养殖中最为严重的疾病之一。 奶牛患乳腺炎疾病会导致产奶量下降、 牛奶质量降低, 会对养殖户造成严重的经济损失[3]。 根据临床症状不同, 奶牛乳房炎主要可分为显性乳房炎和隐性乳房炎[4]。 患有显性乳房炎的部位表现出肉眼可见的红、 肿、 热等症状, 然而, 隐性乳房炎的发病率高且奶牛乳房外观变化细微, 检测较为困难[5]。 早期由于缺乏有效的科技手段, 养殖人员通过人工观察奶牛乳腺炎的发病情况, 判断具有一定的主观性, 误诊率较高。 随着我国奶牛养殖厂的数量规模不断扩大, 急需一种高效、 准确的奶牛隐性乳房炎早期检测方法。

早期比较常规的“ 接触式” 奶牛隐性乳房炎检测方法主要包括直接体细胞计数法(SCC)、 加州乳房炎检测法(CMT)、 电导率法(EC)等等。 此类法均需要对奶牛乳液进行采样, 并通过专业仪器测量样品的理化成分从而判定奶牛是否患乳房炎, 整个过程需要严格控制检测样品的环境条件, 具有实验操作繁琐、 周期长且成本价格昂贵等弊端, 从而限制了其在生产实际中的应用[6, 7, 8]。

红外热成像技术[9](infrared thermograph technology, IRT)近些年来应用领域愈加广泛, 其原理是利用传感器检测物体表面辐射出的电磁波信号, 并转换成视觉可见的热红外图像或视频, 其不同的明亮程度以及颜色代表不同温度从而可以判断患病区域表面温度以及炎症反应程度。 IRT技术作为一种安全、 低成本、 非侵入性的快速疾病筛查方法, 可以在早期发现乳腺病变, 基于IRT的“ 非接触式” 畜类乳腺炎检测方法开始受到研究人员的关注。 Zaninelli[10]等将采集到的奶牛热红外像图像通过应用软件计算每个乳房的温度数据, 结果证实了奶牛乳房表面温度与其牛奶样品中的体细胞数量之间存在显著相关性。 Bartolome[11]等通过热红外图像以及心率来评估动物眼睛温度, 研究表明动物的眼睛显示出最高的温度代表最接近内部核心体温的温度。 Sathiyabarathi[12]等采用IRT技术检测奶牛体温和乳房表皮温度(USST), 结果表明: 患乳腺炎的部位平均USST高于平均体温0.8 ℃。 因此, 研究者们提出采用热红外热像仪测量奶牛眼睛和乳房等关键部位温度, 可以作为奶牛乳房疾病判断依据。

Metzner[13]等采用不同的几何工具手动测量出奶牛热红外图像关键部位, 并通过受试者工作特征曲线(receiver operating characteristic, ROC)分析比较出最佳检测方法。 然而人工标记很容易产生误差, 且消耗大量人力。 为了实现奶牛乳房炎的自动检测, 张旭东[14]等提出了一种基于阈值分割的奶牛眼睛和乳房自动定位算法, 并根据温度阈值对奶牛乳房炎发病程度进行评级, 结果表明, 一级奶牛乳腺炎检测准确率为87.5%, 二级的检测准确率仅有33.3%。 该研究中的分割方法对噪声敏感, 关键部位定位误差大, 导致二级乳腺炎检测准确极低。

随着深度学习在计算机视觉领域的不断发展, 卷积神经网络(CNN)对大规模的数据具有强大的学习功能, 在复杂背景的目标检测场景中取得了显著的成绩[15]。 为了提高奶牛关键部位的识别准确度, Xudong[16]等提出了一种基于热红外图像的EFMYOLOv3深度学习算法, 该方法定位平均精确率达到96.8%, 乳腺炎分类准确率为83.33%。 王彦超[17]等提出了一种改进YOLO v3-tiny的奶牛乳房炎检测方法, 奶牛乳房炎检测精度可达77.3%。 然而, 在实际场景中由于运动目标的测量距离、 角度、 环境等因素都会造成测量温度漂移, 再经过与阈值比较, 误差扩大, 严重影响到最终的乳腺炎分类。 无论是目标检测或是图像分割法均需定位识别出奶牛的眼睛、 乳房等关键部位, 其次通过特定软件从每头牛奶的多张图片中提取出该区域温度, 然后将其与标准理化指标进行比较。 这种“ 多步式” 的检测方法不仅过程冗余复杂, 而且很容易由于外部因素造成误差累计, 因此更需要一种从输入数据到得出最终结果, 无需其他人工操作步骤的“ 端到端” 奶牛乳腺炎检测方法。

针对上述问题, 为了实现更快速、 更高精度的“ 一步式” 奶牛乳腺炎疾病检测, 本工作提出一种基于热红外图像拼接的改进ResNet34奶牛乳腺炎检测算法。 无需人工手动标记奶牛热红外数据, 首先将原始局部图像拼接成完整图片, 再采用RandAugment数据增强技术扩充数据集, 最后基于迁移学习和改进ResNet34算法直接对奶牛热红外图像进行识别, 将奶牛乳腺状况进行分类(患病或正常)。

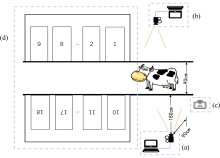

实验数据来自于北京市延庆区大地集团的荷斯坦奶牛养殖场。 采集时间控制在上午8— 10点时间段内, 采集地点设置在养殖场室内。 数据采集场景如图1(a— d)所示, 泌乳期奶牛依次通过宽度为90 cm的入口通道进入挤奶厅(18台挤奶仪器), 入口处的射频识别(RFID)装置用以记录视频中每一头奶牛的ID号, 入口通道两侧分别安装一台固定拍摄装置— — FLIR A310热像仪(FLIR系列, 美国)。 为确保热像仪能拍到实验对象的关键部位, 并减少视野盲区, 热像仪镜头(FOL 18 mm)与通道直线距离180 cm, 镜头高度设置为90 cm。 按照实际情况调整热成像仪的反射温度、 相对湿度并设置其发射率为0.98, 与Zaninelli等[10]研究保持一致。 采用FLIR Tools的Altas SDK图库记录360头奶牛的热红外视频(视频的格式为SEQ, 像素大小为320× 240), 并通过体细胞分析仪对采集的牛奶样品进行检测。 根据Zaninelli等[10]的研究表明: 当SCC值大于或等于20 W· mL-1时, 奶牛的该乳房部位被确认为患有乳腺炎。

实验共计获取360头奶牛热红外视频。 SCC检测结果显示29头奶牛患有乳腺炎疾病, 为了使数据较为均衡, 随机挑选37头正常奶牛, 共计66头奶牛选为最终实验对象, 然后通过MATLAB R2018b将其SEQ视频按照15 fps速率分帧成像素大小为320× 240, 格式为jpg的原始热红外图片。

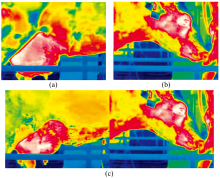

采集过程中, 自然行走的奶牛由于运动导致眼睛和乳房无法一直保持在同一帧画面之中。 为了增强有关信息的可检测性, 本研究提出一种奶牛热红外图像拼接方法: 将同一头奶牛连续帧中单独包含眼睛或乳房的局部图片, 一对一水平拼接成同时包含眼睛和乳房的整体图片[图2(a, b, c)所示]。 这样既保留了数据处理前后的时空联系, 又解决了动态目标导致的数据特征缺失问题。 根据上述预处理方法共得到2 234张(37头)正常、 1 064张(29头)患病奶牛热红外图像, 并将样本数量按照3:1:1划分训练集、 验证集、 测试集。 划分结果如表1所示。

| 表1 数据划分结果 Table 1 Data division results |

数据增强是以提高深度学习模型的鲁棒性为目的, 从同源数据中产生具有相同的标签的样本, 扩充训练数据集的技术。 深度残差网络一贯的数据增强方式是: 在模型训练过程中将获得每一批数据进行增强与变换, 具体过程是: 首先将图像按比例缩放像素大小为256× 256, 然后对图像进行随机裁剪为224× 224, 最后将像素进行归一化处理。

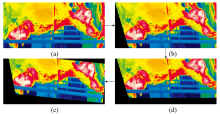

为了进一步提升样本多样性, 在原有数据增强的基础上结合RandAugment数据增强新方法。 当数据增强操作使得增强样本和原样本之间的分布产生了较大的差异, 反而会降低模型性能, 因此从RandAugment操作集中剔除与本实验有负影响的4种操作, 其余10种操作分别为: 自动明暗对比(AutoContrast)、 均衡化(Equalize)、 旋转(Rotate)、 色调分离(Posterize)、 对比度(Contrast)、 锐化(Sharpness)、 沿X轴错切(Shear-X)、 沿Y轴错切(Shear-Y)、 沿X轴移位(Translate-X)、 沿Y轴移位(Translate-Y)。 RandAugment有两个关键性参数: N和M, 即每次数据增强子策略按照1/10等概率原则选取N种操作方法, 每种操作使得图像形变程度为M, 共有10N种生成图像。 数据增强的最佳强度取决于模型大小和训练集大小, 过于极端的增强操作可能会产生一定的信噪比, 从而导致数据增强效果适得其反。 图3(a— d)展示的是当N=3、 M=15时使用RandAugment数据增强, 经过包含沿X轴错切、 沿Y轴移位和旋转三种增强方式的增强子策略所生成的效果图。

迁移学习是一种运用已有知识对相关领域问题进行求解, 在经验信息的基础上使得快速解决新任务能力的机器学习新方法。 从图像分类流程来看, 参数迁移属于迁移学习主要方式之一, 参数迁移可以使得模型训练过程具有一个较好的初始状态, 能有效缩短训练时间[18]。 ImageNet是一个具有超过1 400万图像, 2万多个类别的大型可视化数据库, 其样本类别覆盖范围广、 种类丰富多样。 奶牛热红外数据与ImageNet中动物图片在纹理、 色彩、 结构等方面有相似的宏观特征[19]。 本研究选用参数迁移学习方法进行模型训练, 将深度残差网络模型在ImageNet上预训练参数权重加载到所搭建好的模型中进行网络的微调, 若预训练权重与新构建网络层匹配则保留其值, 反之, 不匹配层(改进部分)使用默认随机参数初始化, 训练过程不冻结任何网络层。

深度残差网络(deep residual network)由2015年微软亚洲研究院的He等所提出, 其核心思想— — 短路机制巧妙的缓解了传统卷积层中由于深度增加导致网络退化问题。 近年来, 残差网络各种变体模型应时而生, 在图像分类、 目标检测、 以及语义分割等领域取得突破性进展[20]。

ResNet34作为深度残差网络的一员, 其表征能力和学习能力较高且模型参数较少, 是图像分类领域研究的热点方向, 因此本研究采用ResNet34残差网络作为实验的基础网络。 ResNet34首先采用7× 7卷积层和3× 3最大池化层下采样减小输入图像特征尺寸, 然后通过layer1— layer4提取高层特征信息, 并经过自适应全局平均池化层输入到全连接层, 最后进行分类输出。 其中每一层layer分别包含3, 4, 6和3个BasicBlock模块, BasicBlock架构如图4(c)所示: 主要使用了两个3× 3的卷积、 批归一化处理、 ReLU激活函数等操作, 再将深层特征与捷径连接传递的低层信息相加。 当BasicBlock输入和输出数据维度一致时其残差支路不做任何变化(路线②), 否则, 利用卷积层进行下采样, 并相应改变通道数量(路线①)。

实验的数据采集场景单一, 与自然可见光图像相比, 热红外图像纹理清晰, 色彩、 明亮对比度明显。 针对红外热成像自身的特点, 为了使该模型更适用于奶牛乳腺炎分类任务, 提出一种改进ResNet34网络结构, 该结构如图4所示, 其中(a)部分表示模型内部层数改进, (b)为新增辅助分类器, (d)和(e)为多融合池化层。 图5为每层网络的特征图可视化。

1.5.1 网络层数改进

冗余的特征以及权重会使网络模型占用更多的内存资源, 为了在最大限度地保持模型准确性的同时实现高效深度学习, 对Layer层进行轻量化, 如图4(a)所示: 将传统ResNet34模型内部四层Layer分别包含3, 4, 6和3个BasicBlock精简化为3, 2, 2和3个残差单元, 保留浅层以及深层的特征提取层, 删减部分中间层从而大幅度压缩空间、 降低计算量, 达到速度与准确率之间的平衡。

1.5.2 多融合池化层

最大池化可以提取具有强烈的语义信息和纹理特征; 平均池化可以更多地保留图像背景信息。 传统ResNet34残差网络使用单一的最大或平均池化进行特征图降维, 可能会导致有用信息丢失。 为尽量避免类似情况发生, 设计了新的池化层如图4(d)和(e)部分所示: 将大小为3× 3、 步长为2的最大池化层与平均池化进行融合, 结合两者优势, 在降低特征维度的同时增强网络的非线性表达能力使得提取内容更加丰富。 前向传播时具体计算公式如式(1), 假设由输入特征图X对应池化窗口的值可以计算输出特征图Y中某一位置的值, 则

式(1)中, n表示特征图号, c是通道号, h是行号, w是列号, s为步长大小, kh和kw是池化窗口的长、 宽大小。

1.5.3 辅助分类器

基于GoogLeNet网络在中间层添加辅助分类器促进模型更稳定学习和更好收敛的思想, 本研究分别在Layer2和Layer3的输出层设置两组辅助分类器, 获取更多的浅层以及中间层信息, 弥补由于模型精简带来的特征损失。 如图4(b)部分所示: 辅助分类器由大小为3× 3的多融合全局池化层与全连接层组成并输出辅助分类结果, 其输出并不影响主分类器的分类结果, 而是在反向传播时额外增加两个浅层网络的Loss损失值。

在分类问题中, 假设模型预测第i类的概率为Pi, 则交叉熵损失函数值L的表达式如式(2)

式(2)中, N为样本个数, yi表示样本i的标签(正类为1, 负类为0)。

设新增辅助分类器的损失值表达式如式(3), 则利用辅助分类器后总的损失函数值表达式如式(4)

其中, M为辅助分类器个数,

选取查准率、 查全率、 特异性、 F1分数作为最终的模型性能评价指标, 具体表达公式如式(5)— 式(8)

式(5)— 式(8)中的TP表示模型预测为正的正样本数量, TN表示模型预测为负的负样本数量, FP表示模型预测为正的负样本数量, FN表示模型预测为负的正样本。

实验硬件环境: Intel i9-10900K处理器、 NVIDIA GTX3060GPU、 64G内存、 12G显存; 软件环境: Ubuntu18.04操作系统、 PyTorch1.9.0深度学习框架、 Python3.8.11编程语言、 PyCharm集成开发环境、 CUDA11.4。 设置模型参数: Batch-size为32、 Adam优化器、 交叉熵损失函数。

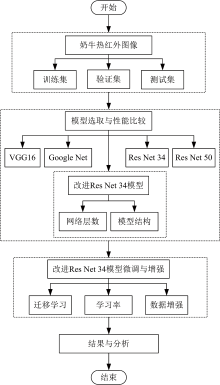

实验流程如图6所示, 首先将处理好的实验数据应用于几种经典深度学习网络模型, 并根据验证准确率、 测试准确率、 平均训练时间等指标对改进ResNet34模型与其他模型性能进行比较; 然后基于改进ResNet34模型结合迁移学习、 数据增强、 学习率进行微调, 最后根据实验结果进行评价与分析。

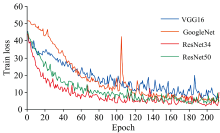

将改进ResNet34与四种传统经典网络模型— — VGG16, GoogLeNet, ResNet34, ResNet50的奶牛乳腺炎分类性能进行对比。 设置模型参数: 训练轮数为200、 学习率为0.000 1。 改进ResNet34模型中辅助分类器的衰减系数按照层数由浅至深将其分别设置为0.1, 0.2和1。 实验结果如表2所示, 从表中可以看出ResNet系列网络的验证准确率明显高于其他模型, 其中ResNet34与ResNet50测试准确率仅相差0.2%, 经过模型改进以后ResNet34测试准确率比ResNet50高0.8%; 改进前后的ResNet34模型平均检测速度相差无几, 均处于优势地位, 但改进后模型的分类速度提升5.9%, 测试准确率提升了1%; VGG16在几种模型中训练时间最久, 分类准确率相对较低; GoogLeNet模型总体性能处于中游。 从训练损失图7中可以看出ResNet34模型拟合速度相对较快, 稳定后的Loss值相对最低。

| 表2 不同模型性能比较 Table 2 Performance comparison of different models |

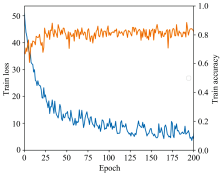

图8展示了改进ResNet34模型性能, 由图可知改进ResNet34模型在训练过程中收敛速度较快, 大约在第30个Epoch时模型训练准确率达到88.4%, 证明所提出的改进模型具有较好的分类效果。 为了进一步提高模型性能, 以改进ResNet34模型为基础进行实验。

2.2.1 迁移学习对网络性能的影响

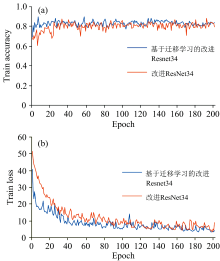

为了比较迁移学习对改进ResNet34模型性能的影响, 设置模型参数: 训练轮数为200、 学习率为0.000 1。 实验训练结果准确率如图9(a, b)所示: 基于迁移学习的改进ResNet34模型训练准确率比未迁移的改进ResNet34模型高大约1.3%, 迁移之后模型的初始性能更高, 训练过程中模型收敛速度更快、 训练损失更小。

| 图9 迁移学习对模型训练结果影响对比 (a): 模型训练准确率; (b): 模型训练损失图Fig.9 Comparison of the effects of transfer learning on model training results (a): Model accuracy; (b): Model loss map |

2.2.2 数据增强对模型性能的影响

为了比较数据增强对改进ResNet34模型性能的影响, 参照RandAugment原作者实验以及本文数据实际情况, 设置参数N和M分别为3和15。 设置模型参数: 训练轮数为500、 学习率为0.000 1。 实验结果如图10(a, b)所示: 数据增强后模型的训练准确率高于未增强模型1.5%, 但模型拟合速度有些许变慢, 损失值有所上升。 该组实验证明在一定程度上数据增强可以提高本实验模型的分类准确率, 但还有很大提升空间。

| 图10 数据增强对模型训练结果影响对比 (a): 模型训练准确率; (b): 模型训练损失图Fig.10 Comparison of the effects of data enhancement on model training results (a): Model accuracy; (b): Model loss map |

2.2.3 学习率对模型性能的影响

学习率主要控制模型到达最优点过程中权重的更新步长, 为了比较不同学习率对模型性能影响, 设置四组对照实验。 实验结果如表3所示: 当学习率为0.000 1时改进ResNet34模型的分类准确率达到相对最优; 当学习率小于0.000 01时模型性能出现退化。 决定选择学习率为0.000 1进行最终的改进ResNet34模型训练。

| 表3 不同学习率下的模型训练结果对比 Table 3 Comparsion of model training results between different learning rates |

2.2.4 综合数据增强与迁移学习对模型性能影响

上述实验分别证明了迁移学习、 数据增强以及调整学习率对于改进ResNet34模型性能都有一定的提升。 为了探究综合以上几种方式对改进ResNet34模型性能的影响, 设置模型参数: 训练轮数为600, 学习率为0.000 1, RandAugment中N=3, M=15。 实验结果表明: 融合迁移学习和数据增强的改进ResNet34模型的每张图片检测时间达到0.003 39 s, 验证准确率达到90.3%, 测试准确率为88.4%, 分别比传统ResNet34模型分类准确率高5.3%和2.9%。 由此证明了融合迁移学习和数据增强对改进ResNet34模型训练效果以及分类准确率有很大的帮助。

2.3.1 模型性能评价

为了评估融合迁移学习和数据增强的改进ResNet34网络模型对于奶牛乳腺炎疾病检测的性能, 对从未参与训练过程的测试样本进行预测, 结果如表4所示。

| 表4 测试集混淆矩阵结果 Table 4 Test set confusion matrix results |

由表6以及式(5)— 式(8)计算出改进ResNet34网络模型在测试集上查准率为91.2%、 查全率为91.6%、 特异度为0.818、 F1分数为0.914, 表明本研究提出的奶牛乳腺炎检测算法分类能力强且模型具有良好的稳健性。

在基于红外图像的奶牛乳腺炎疾病检测领域中, 文献[14]提出一种基于阈值分割奶牛乳腺炎疾病检测方法, 一级和二级奶牛乳腺炎检测准确率分别为87.5%和33.3%。 文献[16]改进的深度学习网络, 对奶牛乳腺炎疾病检测率的83.33%, 文献[17]提出的一种改进YOLO v3-tiny的奶牛关键部位检测方法, 奶牛乳房炎检测精度为77.3%。 从表5中可以看出, 所构建的改进ResNet34算法的奶牛乳腺炎分类准确率在相关研究中表现出色, 证明了本研究所提出的方法具有明显优势。

| 表5 相关研究结果对比 Table 5 Comparison of relevant research results |

2.3.2 模型的泛化性评价

为了证明本研究方法的泛化性, 需进一步保证各数据集之间样本的独立性, 将奶牛个体数量按照3:1:1划分为训练集、 验证集和测试集, 划分结果如表6所示。 将数据样本送入融合迁移学习和数据增强的改进ResNet34模型中, 并设置上述实验相同的模型参数。 实验结果如表7所示, 按照奶牛个体数量划分数据测得模型的分类效果同样令人满意, 证明本文所提出的融合迁移学习和数据增强的改进ResNet34模型对未知奶牛患乳腺炎的疾病检测准确率达到80%以上, 该模型具有很好的鲁棒性以及有效性。

| 表6 按照奶牛个体划分数据 Table 6 Data results by number of cows |

| 表7 按照奶牛个体划分数据检测结果 Table 7 Test results according to individual cows |

基于残差网络提出了一种改进ResNet34模型, 通过模型精简以及引入辅助分类器模块和多融合池化层, 能够有效提高奶牛热红外图像乳腺炎检测准确率, 缩短分类时间。 经过与几种经典深度学习模型对比, 在考虑迁移学习、 学习率、 数据增强以及数据集划分方式等因素影响的情况下, 设置多组对比实验, 实验结果表明: 当学习率为0.000 1时, 融合迁移学习和RandAugment数据增强的改进ResNet34模型测试准确率为88.4%, 高于传统ResNet34模型2.5%。 通过混淆矩阵计算出模型查准率为0.912、 查全率为0.916、 F1分数为0.914, 证明本研究所提出的奶牛乳腺炎检测模型具有很好的健壮性与鲁棒性。 与前人基于热红外图像奶牛乳腺炎研究相比, 本方法无需人工手动标记样本, 能有效避免中间操作造成的误差累计, 疾病检测准确率较高且平均检测时间仅需约0.003 39 s, 本研究可以提高奶牛乳腺炎早期检测的识别效率, 为牛场管理人员科学养殖提供参考。 然而, 由于本研究依赖于奶牛的热红外数据, 而固定的采集设备很难捕获到包含完整目标的数据, 且关键部位(乳房、 眼睛)的位置影响温度的获取。 因此, 在后续研究中, 还需进一步提高数据采集设备, 例如: 利用深度相机与可移动、 便携式热像仪获取带有位置信息的优质数据集, 提高关键部位温度读取精度, 增强奶牛乳腺炎检测系统性能。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|