作者简介: 李凯雨, 女, 1994年生, 中国农业大学信息与电气工程学院博士研究生 e-mail: 1162103154@qq.com

病害严重影响作物品质, 并造成经济损失。 病斑分割是病害定量诊断的重要过程, 其分割结果可为后续的识别和严重度估算提供有效依据。 由于病斑具有不规则性和复杂性, 且自然环境下病斑可见光谱图像易受光照变化等影响, 传统的图像处理方法对病斑图像分割存在准确率低、 普适性低和鲁棒性不高等问题。 该工作提出了基于语义分割和可见光谱图像的作物叶部病害病斑分割方法。 首先, 以花生褐斑病、 烟草赤星病为研究对象, 使用尼康D300s单反相机共采集到165张可见光谱图像。 通过Matlab Image Labeler APP对病害可见光谱图像进行像素标记, 分别标记出褐斑病病斑、 赤星病病斑和背景区域。 其次, 对标记后的数据采用水平翻转、 垂直翻转、 改变亮度等图像扩充方式, 获得1 850份增强后样本数据集。 为了节约计算成本, 将数据集的像素分辨率调整为300×300。 最后, 基于FCN, SegNet和U-Net 3种语义分割网络, 构建4 种作物叶部病害病斑分割模型, 探索了数据增强、 病害类别对病斑分割模型的影响, 并采用4种分割指标评价模型效果。 结果表明: 仅对于病斑分割, 图像增强能够提高模型的分割精度, 增强后FCN模型的平均精度(MP)和平均交并比(MIoU)分别为95.71%和93.36%。 4个语义分割模型显著优于支持向量机(SVM), 其中FCN与U-Net, SegNet-2和SegNet-4分割模型相比, 能够有效避免光线变化等影响, 病斑分割精度( P)和交并比(IoU)分别达到99.25%和97.55%。 对于病斑分类分割实验, FCN对两种病害的分割精度 Pd分别达到97.54%和90.41%, 对两种病害的交并比IOUd分别为95.61%和70.30%, 均优于其他3种分割模型。 FCN能够在分割病斑的同时也准确地识别病害类别, 有较好的泛化性和鲁棒性, 实现了自然场景下作物叶部病害病斑的识别与分割, 为计算混合病害严重度提供了技术参考。

Diseases affect crop quality seriously and cause economic losses. Disease spot segmentation is an important process of identification and disease severity estimation, whose segmentation results can provide an effective basis for subsequent identification and severity estimation. Due to the irregularity and complexity of lesions, and the visible spectrum image of lesions in the natural environment is susceptible to be change in illumination, traditional image processing methods have low accuracy, low universality and robustness for image segmentation of lesions. In this regard, this article proposed a method for the segmentation of crop leaf diseases based on semantic segmentation and visible spectrum images. Firstly, taking peanut brown spot and tobacco brown spot as the research objects, 165 visible spectrum images were collected using a Nikon D300s SLR camera. The visible spectrum images of the diseases were pixel-labeled through the Matlab Image Labeler APP, and the brown spot and background area were respectively marked. Secondly, the labeled dataset adopted image enhancement methods such as horizontal flipping, vertical flipping, changing brightness, etc., to obtain 1 850 enhanced sample data sets and randomly divided them into the training set, validation set and test set according to the ratio of 8∶1∶1. At the same time, in order to save computational cost, the pixel resolution of the data set was adjusted to 300×300. Finally, four types of disease spot segmentation models were constructed based on the three semantic segmentation networks of FCN, SegNet and U-Net. The effects of data enhancement and disease types on the lesion segmentation model were explored. Four segmentation indicators were used to evaluate the model’s segmentation effect. The test results showed that only for lesion segmentation, image enhancement could improve the segmentation accuracy of the model. The model’s Mean Precision (MP) and Mean Intersection over Union (MIoU) were 95.71% and 93.36%, respectively. The 4 semantic segmentation models were significantly better than the Support Vector Machine (SVM). Compared with the U-Net, SegNet-2 and SegNet-4 segmentation models, FCN can effectively avoid the influence of light changes. The Precision ( P) of lesion segmentation and the Intersection over Union(IoU) reached 99.25% and 97.55%, respectively. For the lesion classification and segmentation experiment, the Precision ( P) of FCN for the two diseases reached 90.41% and 97.54%, and the Intersection over Union(IoU) of the two diseases reached 95.61% and 70.30%, respectively, which were better than the other three segmentation models. FCN can distinguish disease types well while segmenting disease spots, which has good generalization and robustness and realize the identification and segmentation of disease spots in natural scenes and provide a technical reference for the severity estimation of mixed diseases.

作物在生长过程中, 病害是降低全球农业生产产量和质量的主要因素之一[1]。 病害叶片病斑分割是病害识别和病害严重度估算的重要过程, 其分割结果直接影响到后续识别和估算的结果。 由于作物病害病斑具有其特殊性、 复杂性和无规律性, 使得病斑分割方法研究颇具挑战[2]。

目前大多数病斑分割研究主要依赖于数字图像处理技术和深度学习技术。 数字图像处理技术在农业可见光光谱图像中应用广泛[3, 4, 5]。 许多研究者将颜色变换与形态学操作、 阈值处理等相结合[3, 6], 实现病斑分割。 这些算法有效地实现了受控条件下的植物叶部病斑分割, 然而这些方法依赖于特征提取, 使得分割方法难以应对自然场景下的病斑分割。

近年来, 深度学习得益于能够自动学习图像中的低级特征及高级特征, 基于语义分割的深度学习模型能够通过卷积层自动学习图像的有效特征并完成像素点分类, 可以实现端到端训练, 能够提升分割精度和鲁棒性[7, 8]。 王璨等[9]采用ResNet-101作为主干网络, 并引入注意力机制优化幼苗期玉米分割, 平均交并比达到94.16%, 能够避免田间杂草对玉米幼苗识别精度的影响。 顾兴健等[10]为分割PlantVillage数据集中的番茄叶部病害, 设计一种基于多尺度残差块的Unet网络, 最终得到平均像素准确率高于86%。 孙俊等[11]将近红外与可见光图像融合成4通道图像, 使用深度可分离卷积和残差块构成卷积层, 构建编码与解码的甜菜与杂草分割模型, 平均交并比达到87.58%, 实现细化分割。 上述研究表明语义分割方法在作物分割中取得了比图像处理技术更好的效果, 增强了分割的鲁棒性, 但是鲜少用于叶部病害病斑的分类分割过程中。

以花生和烟草等经济作物为研究对象, 采集花生褐斑病和烟草赤星病可见光光谱图像为样本, 对于病斑分割分类问题, 本研究提出了基于语义分割和可见光光谱图像的叶部病斑分割方法, 选择常用的全卷积神经网络(fully convolutional networks, FCN)、 SegNet和U-Net等语义分割网络进行试验对比分析, 并在网络的末端修改像素级分类器数目, 使分类器可以精准输出病斑分割图以及不同病害的分割图。

所使用的病害图像采集于河南新乡、 许昌等地, 在田间自然光照下采用尼康D300s单反相机, 选取自动曝光模式。 采集环境: 在大田中, 适合的光照环境, 不在阴暗或正午强光下拍摄; 且为了适应实际应用中多种背景的要求, 在取样时选取不同的背景, 镜头与目标叶片取适中距离并清晰地采集样本可见光光谱图像。 实验采集花生褐斑病、 烟草赤星病可见光光谱图像, 样本图片共计165张, 以.jpg格式存储在电脑中。 由于采集样本时, 所取背景较为复杂, 噪声较大, 且花生图像中出现多个叶片, 为提高识别精度, 在采集后做精细分类、 清洗、 裁剪等处理。 图1为烟草赤星病和花生褐斑病病害的原始可见光光谱图像。

针对采集到的烟草赤星病和花生褐斑病可见光谱图, 采用MATLAB中Image Labeler APP进行标注, 标注完成的标签中像素点分为三个类别, 其中, 类别0表示背景, 类别1和2分别表示褐斑病病斑和赤星病病斑。

获取的两种病斑和背景之间类别分布不均匀, 会影响模型识别的准确率[12], 故为丰富数据集的多样性, 均衡样本数量, 促进模型学习, 采用翻转、 颜色抖动等操作进行样本图像数据增强。 同时使用类别权重均衡各类别。 增强后的样本数据集为1 850张, 并按照8∶ 1∶ 1的比例将1 850张叶部病斑图像随机划分为训练集、 验证集和测试集, 最终训练集包含1 480幅图像, 验证集和测试集分别包含185幅图像。 为了减少计算消耗, 提高网络的训练效率, 将数据集调整为300× 300像素。

构建基于语义分割和可见光光谱图像的作物叶部病斑分割模型, 保证在输入为任意尺寸的叶部病害可见光光谱图像时, 能够输出相同尺寸的分割图像, 分割出花生褐斑病和烟草赤星病的病斑。 FCN直接应用传统的VGG, 改全连接层为卷积层, 通过上采样操作来恢复丢失的空间信息, 实现像素分类。 该分割模型是在卷积神经网络的基础上进行改进, 不受限地输入, 真正实现了点对点、 端对端的图像分割, 提高了分割效率。 SegNet是由对称的卷积结构及像素级分类器构成的全卷积神经网络, 编码器提取特征信息, 并引用最大池化索引, 避免模型重学习, 解码器将低级特征图和编码部分对应连接, 保留位置信息; SegNet-2有两个编码-解码模块结构, SegNet-4有四个编码-解码模块。 U-Net采用不同层之间的跳跃连接来融合多层级特征实现更精细的分割。

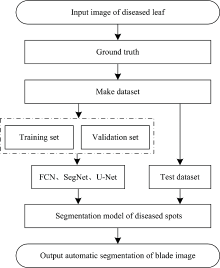

使用几种经典的语义分割模型, 以300× 300× 3为统一输入尺寸, 分割模型通过训练集学习网络参数、 验证集进行参数调优, 最终测试集用于评估模型性能, 具体试验流程如图2所示。

病斑分割的过程中, 主要考虑病斑的定位分割及病斑种类识别, 因此考虑用精度(precision, P)、 类别平均精度(mean precision, MP)、 交并比(intersection over union, IoU)和平均交并比(mean intersection over union, MIoU)等指标进行评价。 各个指标计算见式(1)— 式(4)。

$\text{MP}=\frac{\overset{n}{\mathop{\mathop{\sum }_{i=1}}}\,{{P}_{i}}}{n}$(2)

$MIoU=\frac{\overset{n}{\mathop{\mathop{\sum }_{i=1}}}\,Io{{U}_{i}}}{n}$(4)

式中, n是分割时的类别数; TP, FP和FN通过混淆矩阵获得的。

在Window 10专业版下采用Matlab 2019a编程实现, 硬件环境为Intel Xeon E5-2620 CPU 2.9 GHz, 32GB内存, NVIDIA Quadro P2000。 训练过程中, 采用梯度下降算法(stochastic gradient descent, SGD)和0.9的动量因子(Momentum), 损失函数为交叉熵(cross-entropy), 学习率和图像批处理大小分别设置为0.000 1和4, 最大训练次数设置为100, 并使用L2正则化以防模型过拟合, 对比试验参数设置相同。

由表1可知, 在对叶部病斑进行自动分割的过程中, 未使用数据增强的FCN1模型的病斑精度Pd为97.01%, 病斑的交并比IoUd为95.61%, 平均精度MP为94.73%, 平均交并比MIoU为87.87%, 满足叶部病斑的分割需求。 对于FCN2模型, 使用数据增强处理后4个指标均有明显提升; 精度分别提升了2.24和0.98个百分点, 交并比分别增加了1.94%和5.49%, 说明增加数据量有助于模型更有效地学习。 后续基于数据增强处理开展模型的对比试验。

| 表1 数据处理方法的对比测试统计结果 Table 1 Comparison test results of data processing methods |

为了验证基于语义分割的病斑分割模型效果, 将FCN与SegNet-2, SegNet-4和U-Net进行了对比。 对于病斑和背景分类, 其分割结果如表2所示。 FCN模型的Pd为99.25%, IoUd也高达97.55%, 模型的MP和MIoU分别为95.71%和93.36%, 在病斑分割任务中表现最好; 其次是U-Net模型, 其病斑分割的Pd为96.47%, IoUd为94.20%, 但其模型整体的MIoU偏低为85.56%, 会出现过分割现象; 第三是SegNet-2模型, 分割精度在93%左右, IoUd为92.35%, 对于病斑的分割表现较好, 但其MIoU不高, 存在将背景误分为病斑的现象; 最差的是SegNet-4模型, 其MP为93.24%, 对背景的识别精度较高, 但病斑分割精度为87.07%且最低, IoUd为84.81%且最低。 因为FCN8s使用跳跃结构融合了更多层次、 更丰富的特征, 使得在像素分类任务上表现较好; U-Net是将早期的卷积层结果和最后几层的结果采用级联的形式作为新的神经网络层, 也能够更好地获得边缘信息。 两个模块的SegNet-2网络均能实现病斑分割, 四个模块的SegNet-4网络效果稍差。

| 表2 不同分割模型的测试结果统计对比 Table 2 Comparison test results of different segmentation methods |

为了验证语义分割模型的准确率, 本研究与机器学习的病斑分割模型进行比较分析。 根据病斑特点, 提取RGB颜色空间、 HSV颜色空间、 L* a* b颜色空间、 YcbCr颜色空间和HSI颜色空间等五个颜色空间15个颜色通道的一阶矩和二阶矩, 并在此基础上提取对比度、 相关性、 能量和同质性等4个纹理特征, 然后进行特征优选。 最终使用33个图像特征作为输入, 构建基于支持向量机(support vector machine, SVM)的病斑分割模型, 其Pd为63.33%, 模型的MP为81.67%, MIoU为70.42%, 分割结果均低于以上四种基于语义分割的病斑分割模型。 分析认为SVM的输入是人为选取确定的特征, 有一定的局限性, 而基于语义分割的病斑分割模型都是使用卷积层自动学习图像特征[11], 没有特征类别和数目的限制, 有更好的分割效果。

随机选取烟草赤星病和花生褐斑病测试图各一张, 四种自动分割模型的测试结果如图3所示。 FCN模型能够较好地自动分割病斑; U-Net模型存在明显的过分割现象, 无法消除背景的干扰; SegNet-2和SegNet-4存在欠分割现象, 赤星病病斑没有进行完全分割。

病斑分类分割对比实验是花生褐斑病病斑、 烟草赤星病病斑和背景三分类任务。 将FCN与SegNet-2、 SegNet-4和U-Net分割模型进行对比, 结果如表3所示, d1是指花生褐斑病, d2是烟草赤星病。 FCN对两种病害的Pd分别达到90.41%和97.54%, 模型的MP高达95.29%, 对两种病害的IoUd分别为70.30%和95.61%, MIoU为87.64%, 均优于其他3种分割模型; 在增加分类数目、 区分病斑类别的情况下, 其他3种模型的效果都下降很多, 在自动分割过程中都不能正确区分两种病斑, 相对较好的SegNet-2模型对病斑的Pd只有55.34%和79.95%, IoUd分别为44.30%和72.26%, 存在无法自动分割病斑、 识别不准确的情况; U-Net模型在病斑分割任务中, 对花生褐斑病的分割和识别效果相对较差, 识别褐斑病的准确率只有23.93%, 容易将花生褐斑病分类成烟草赤星病; SegNet-4的分割结果最差, 无法进行病斑的自动分割, 对两种病斑的识别精度都低于50%, 且模型的MIoU只有44.48%。 两种病斑的症状表现比较相近, 由于FCN8s联合了后三个阶段中的特征图, 能够学习到更细致的特征, 所以在这个三分类任务中表现效果更好; 而SegNet-4可能由于网络层次太多, 不适用于本研究两种病害数据集。

| 表3 不同分割模型的测试结果统计对比 Table 3 Comparison test results of different segmentation methods |

4种自动分割模型的测试结果如图4所示。 FCN模型能够较好地自动分割不同的病斑, U-Net和SegNet-2模型会将部分赤星病病斑误分为背景, 将褐斑病误分为赤星病; SegNet-4模型的自动分割效果最差, 对两种病斑的分割完全混乱; 后三种方法对一个病斑目标内的像素点都存在分类错误。

综上所述, 本研究采用构建的基于语义分割和可见光光谱图像的叶部病斑分割模型, 试验并分析了数据增强、 病斑分割和多种病斑分割情况下对作物叶部病害病斑分割的影响, 选用FCN, SegNet-2, SegNet-4和U-Net4种分割模型相对比。 分割结果表明, 基于FCN的叶部病斑分割模型能够在光照条件不均匀和复杂背景的情况下, 准确地获取多种病害病斑的分割图像, 有较好的泛化性和鲁棒性, 实现了自然场景下叶部病斑的识别与分割, 为精准计算混合病害严重度奠定了基础。

通过语义分割方法无需手动设计提取病斑特征, 使用上采样层将网络输出为原始图像尺寸, 采用分割精度、 平均精度、 交并比和平均交并比等4个指标来量化4种分割模型的病斑分割性能。

(1)图像增强机制能够提高模型的分割准确率。 使用数据增强处理后模型的4个指标均有明显提升, 其中病斑精度Pd和平均精度分别提升了2.24和0.98个百分点, 最终分别达到99.25%和95.71%, 病斑的交并比IoUd和MIoU分别提升了1.94%和5.49%, 说明扩充数据量、 增加数据多样性有助于模型更有效的学习。

(2)语义分割模型能够有效提取病斑特征, 提升病斑分割精度。 基于语义分割的4种病斑分割模型均比SVM的分割精度高, 这得益于语义分割模型都是用卷积层来自主学习病斑的高效特征, 不局限于人工设计特征; 4种语义分割模型中, FCN模型的平均精度达到了95.71%, 模型的平均交并比为93.36%, 可为作物病害诊断过程中的分割研究提供一种智能化的技术手段。

(3)FCN模型对叶部病斑分割和分类识别具有良好的泛化能力。 分割两种不同病斑时, 其平均精度达到95.29%, 模型的平均交并比为87.64%, 能够在分割病斑的同时较好地识别病害类别, 为叶部混合病害的定量诊断提供支撑。

FCN模型通过融合病斑可见光图像浅层和深层的多重特征, 能够准确提取病斑信息, 有效分割不规则病斑, 具有良好的病斑分割性能, 该模型可为作物叶部病害的定性诊断和定量估算分析提供科学依据和智能化的技术手段。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|