作者简介: 桂江生, 1978年生, 浙江理工大学信息学院副教授 e-mail: jsgui@zstu.edu.cn

为减轻虫害对大豆的影响, 首先使用相应的高光谱仪器进行样本采集, 样本分为4类: 包括带有微小虫卵的, 带有幼虫的, 有啃食痕迹的和完全正常的大豆各20颗; 然后提出了一种基于三维图像检索(3D-R-D, 3D Resnet18 DCH)的大豆食心虫的高光谱检测方法。 该方法从视频检索的应用中得到启发, 考虑到视频不同帧之间和高光谱不同层之间存在类比关系, 使用了在大规模视频检索数据集下训练而成的分类模型, 将它作为预训练3D卷积模型进行训练。 和已知的文献方法相同, 使用公开的光谱数据集进行正式训练和微调, 从而得到能进行特征提取的3D卷积网络, 用图像检索来实现间接分类, 通过利用样本之间的特征距离, 实现在全新类别上的分类。 为能适应任务, 将模型最后的分类层变成了图像检索常用的hash层, 从而得到了代表特征的二进制码。 该方法不但完成了对不同情况下大豆种类的检测, 还解决了训练时样本不足的问题。 为探寻一种好的相似度匹配损失函数, 对比了多种较新的方法, 最后发现使用融入柯西分布的损失函数, 实验效果最佳, 最终模型的分类精度达86%±1.00%, 和在大豆食心虫检测上最新的小样本方法对比, 3D-R-D方法提高了3.5%左右的精度, 表明该方法是有效的, 它也为结合高光谱检测相关研究提供了一种全新思路。

To reduce the impact of insect pests on soybeans, first use the corresponding hyperspectral instrument to collect samples. The samples are divided into 4 categories: those with tiny eggs, those with larvae, those with nibbling marks, and those with entirely normal soybeans. 20 Then, a hyperspectral detection method of soybean borer based on three-dimensional image retrieval (3D-RD, 3D Resnet18 DCH) was proposed. The application of video retrieval inspires this method. Considering the analogy relationship between different frames of the video and the different layers of the hyper spectrum, the classification model trained on the large-scale video retrieval data set is used as a predictive model. Train the 3D convolution model for training. Same as the known literature method, the public spectral data set is used for formal training and fine-tuning to obtain a 3D convolutional network that can perform feature extraction. Image retrieval is used to achieve indirect classification, and the feature distance between samples is used to achieve classification in new categories. In order to be able to adapt to the task, the final classification layer of the model is turned into a commonly used hash layer for image retrieval, thereby obtaining the binary code representing the feature. This method completes the detection of soybean types in different situations and solves the problem of insufficient samples during training. In order to explore a good similarity matching loss function, this article uses a variety of newer methods to explore and finally found that the Cauchy distribution is integrated into the loss function, which can be effectively applied in this experiment. Experiments have proved that the classification accuracy of the final model is 86%±1.00%. Compared with the latest small sample method in detecting soybean borer, the 3D-RD method improves the accuracy by about 3.5%, which shows that the method is effective. The method also provides a new way of thinking for hyperspectral research.

大豆食心虫成虫的虫卵会附着于大豆表面, 孵化的幼虫会啃食大豆, 对大豆产量和品质造成严重影响。 这种现象在我国各大豆产区普遍发生, 如发现和预防得不及时会使得大豆产量严重下降。

在大豆病害的检测上, 人工可视化调查作为实践中最基本的直接方法, 至今仍在使用。 然而, 这种方法需要相关植物表型和植物病理学的专业知识; 另一种常见的植物病害检测技术可以称为生物分子法, 但生物分子技术需要详细的取样和复杂的处理方法, 与人工调查方法相比, 这些方法更具专业性和周期性。 这两种技术具有基本性、 有效性, 但总是需要手动去检测, 导致复杂的工作和较大的劳动量[1]。

近年来, 深度学习技术在植物病害分类中的成功应用, 为大豆病害的研究提供了新思路, 该技术通过将卷积网络与高光谱结合, 能够对目标进行有效分类。 高光谱技术可视为光谱学的一部分, 它可以从多个光谱带中获取光谱信息, 一些有效波段对病害引起的大豆细微变化具有很高的敏感性, 从而可以区分不同的病害类型。 卷积网络是一种特殊的深度学习技术, 在图像处理和提取特征方面具有突出的能力。

Ma等[2]对玫瑰虫害进行检测, 在对光谱信息进行分析后, 利用CNN模型提取特征, 达到了99%的准确率。 Nguyen等[3]构建了小型的健康葡萄树和感染葡萄树的数据集, 使用CNN进行分类, 使用2DCNN 模型的准确率为71%, 而使用3DCNN 模型的准确率为75%; 在改进之后, 准确率达到了90%以上。 Yan等[4]使用高光谱成像系统(376~1 044 nm)采集感染的叶片样本, 得到光谱图像, 利用3DCNN识别棉花叶片中的蚜虫感染, 达到了90%以上的准确率。

深度学习的效果很好, 但是通常需要大量训练样本, 在ImageNet上预训练的CNN被用于各种计算机视觉任务, 并取得了巨大成功; 使用预训练的CNN模型, 大大减少了训练数据不足带来的问题, 从中受到启发, 我们采用视频检索场景中的预训练模型3D-Resnet18进行特征提取, 在视频检索中, 同一个视频中的不同帧之间是存在联系的, 这和高光谱图像由不同波段组成是相似的, 它们之间的特征可以互补从而丰富这个视频整体的特征[5]。

在使用3D CNN分类的过程中, 首先是利用网络提取特征, 这种特征包含了分类所需的所有信息。 检索的过程也是先对样本进行特征提取, 然后利用特征之间的距离关系进行相似度排序。 不同的是, 为了获得好的效果, 直接分类需要相对大量训练的样本, 并且不能对新的类别进行分类, 而检索则可以有效利用训练样本间的相似度, 使得新类别的测试图像也能够被分类。 利用相似关系进行分类的还有小样本学习分类, 但这种方法的效果较容易受到样本的影响。

提出了一种新颖的基于图像检索的分类方法, 该方法利用样本之间的相关性进行检索, 能够对新的未知类别进行分类。 在对大豆高光谱图像有效分类的同时, 解决了训练样本少的问题, 为其他的分类研究提供了思路。

本实验是在文献[6]的基础上进行改进, 除了方法以外, 采用的数据, 成像系统, 预处理方法与其相似。

测试集中所需要食心虫大豆样本由专业农业机构提供, 将20只成虫放入大豆中使其于大豆上产卵, 5 d后采集附着虫卵的大豆, 10 d后采集附着食心虫幼虫的大豆, 30 d后采集被啃食的大豆。 分别对正常的大豆以及上述三种大豆拍摄高光谱图像, 每类样本数量为20。

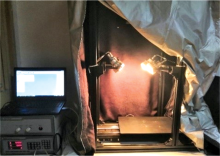

由SpectraVIEW软件进行图像采集, 高光谱成像系统的组成部分有电控平移台, 型号为Imperx IPX-2M30的高光谱成像仪, 4盏功率为150 W的卤素灯, CCD相机, 一台计算机五个部分, 采集的图像包含256个光谱波段。 它们的光谱范围为383.70~1 032.70 nm, 整个采集过程在暗箱中完成, 避免了环境光的影响, 如图1所示。

采集图像时, 曝光时间为18 ms, 平台的移动速度设置为1.50 cm· s-1, 卤素灯与平台之间的夹角设置为50° 。 先采集白板图像W和暗背景图像B, 然后对大豆样本进行图像采集, 得到256个波段的高光谱图像。 采集到的大豆样本合成的RGB图如图2所示。

采集图像过程中为了缓解可能出现的漫反射, 样本不均匀, 基线漂移等问题, 对采集图像进行了Savitzky-Golay滤波处理, 针对光照不均匀的问题, 使用了黑白校正的预处理方法。

高光谱图像的波段数量太多, 许多波段的数据是冗余的; 为了避免这些冗余数据造成的影响, 使用了主成分分析法进行降维处理, 选取前30个高光谱波段作为特征波段。 以样本为中心截取了50× 50像素的正方形区域, 使得单个高光谱样本数据的大小为50× 50× 30。

3D-R-D模型的内容主要包括一个用于提取特征的3D卷积网络, 一个用于帮助网络产生有效特征的DCH[6]损失函数。 其中网络模型为3D-Resnet18, 该预训练模型的原始数据集包括Kinetics-700(K)和Moments in Time(M)两个数据集, 前者一共700个类, 每个类包括超过600个来自YouTube的人类动作视频, 后者是包括100万个视频的数据集, 使用这样的预训练模型, 可以得到较好的初始化参数。

预训练模型并不能直接使用, 在网络结构的改变上, 本工作仅仅去除最后的分类层, 并添加一个从高维映射到低维的hash层, 这样不仅使用了模型中的初始化参数, 还能利用网络训练来进行降维。

在损失函数的设计上, 为得到效果优良的相似度特征, 文献中经常使用成对损失函数来更新这些特征提取算法的可学习参数。 Zhang等[7]通过设计合理的损失函数, 使得每一对输入样本如果相似就让它们的特征相互靠近, 不相似的样本对特征距离相互远离, 充分利用了样本标签之间的相似性; 和Zhang等不同, Liu等[8]对输入图像的监督信息进行编码, 对输出特征进行正则化, 以逼近所需的离散值, 该方法设计了一个阈值m, 当不相似对的特征距离大于m时不提供损失贡献。 Cao等[9]设计了一个基于柯西分布的成对损失, 它对汉明距离大于给定汉明半径阈值的相似图像对造成了显著的惩罚, 也充分利用了标签信息。 Wu等[10]将DSH中的损失函数与交叉熵函数进行结合, 使得最后的特征信息包含分类损失和标签之间的相似度信息。 Yuan等[11]通过引入一个哈达码矩阵, 改进交叉熵损失, 通过添加分类中心, 增强了分类损失的特征信息。

在特征距离的计算上, 由于最后的特征都是低维的二进制码, 所以使用汉明距离进行衡量, 并且由于维度较低, 不同样本之间特征距离的计算速度极快。

如上所述。 本工作使用预训练模型, 并将分类层改为hash层, 损失函数使用的是DCH, 训练集为CAVE, iCVL和NUS, 测试集为采集的大豆样本, 训练时用于微调以适应应用场景的训练集则和文献[6]中描述的一样, 就是使用光谱数据集CAVE, iCVL和NUS作为数据集。 CAVE是一个包含32个场景的数据集, iCVL高光谱数据集由计算机视觉会议收集, 包含农村, 城市, 植物, 公园, 室内这些场景, NUS数据集则包含了一些普通场景和水果, 而上述的四种类别的大豆数据则作为分类实验中的测试集和检索集。 利用图像检索进行分类的步骤如下所示:

(1) 利用训练集训练得到一个网络模型, 这个模型能够对输入的同一类高光谱样本输出相似的二进制特征。

(2) 从大豆样本的每一类中随机取出10个样本组成检索集, 对检索集提取特征并储存到文件A中, 剩下的大豆样本作为测试集。

(3) 模拟新采集样本的分类: 将测试集中每一个样本依次提取特征, 并用汉明距离与文件A中的数据进行相似度匹配排序, 从检索集取出的排名前5个样本中相同标签最多的即为这个测试样本的类别。

(4) 实验得到的准确率即为正确的测试个数占总测试样本数量的比重, 重复上述步骤, 反复实验取平均值。

在最近的大豆食心虫分类研究中, 文献[6]使用了小样本分类, 采用了MN[12], MAML[13], 3D-RN[14]的方法, 也解决了高光谱图像数据样本不足的问题, 它的实验结果如表1所示。

| 表1 不同分类模型在4-way 5-shot情况下的检测结果 Table 1 Detection results of different classification models in 4-way 5-shot |

由此发现, 使用Resnet18的网络结构, 具有良好的效果, 为了研究图像检索进行分类的有效性, 也为了能和文献[6]进行对比, 通过使用不同的预模型, 结合不同损失函数, 设计了如表2实验。

| 表2 不同损失函数下的检索性能 Table 2 Retrieval performance under different loss functions |

在表2中, Resnet18-K表示使用了Kinetics-700(K)为数据集的预训练模型, Resnet18-KM, 表示该预训练模型还使用了Moments in Time(M)数据集, 从实验结果中发现, 尽管使用了更多的数据, 本实验在性能上, 有所提升但是比较细微; 和原来的交叉熵损失函数相比, DH使用成对损失提高了5%的分类准确率, 在使用M阈值之后, DSH又有所提高, DSHSD尽管结合分类损失和成对损失, 但是性能和DSH几乎没有区别, 由此可见, 单纯的分类损失并不适用于本次实验, CSQ引入了中心损失, 在改善交叉熵后, 确实提高了5%左右的准确率, 和DSH差不多, 而DCH在使用柯西分布后, 达到了86%的准确率, 相比于之前效果最好的3D-RN实验, 提高3.5%的准确率。

近年来, 使用高光谱成像对农业病虫害检测已经应用地十分广泛, 但是样本数量少的问题仍然需要解决, 本文通过采集不同时期的样本, 利用样本之间的相似度信息, 构建了一种基于图像检索的分类方法, 在模型上, 从视频检索中得到启发, 利用大量数据训练的3D预训练网络, 获得了较好的初始化参数, 利用3D CNN, 使得不同波段间数据的相似性能够被利用起来, 通过对不同损失函数的比较, DCH利用柯西分布, 能较好地提取到样本之间地相似信息, 它的准确率达到了86.0± 1.00, 从而解决了实际问题, 这是一种新颖的高光谱检测方法, 为高光谱检测的相关研究提供了一种新的思路。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|