作者简介: 邓诗宇, 1990年生, 中国科学院国家天文台长春人造卫星观测站博士研究生 e-mail: dengsy@cho.ac.cn

随着近年来光谱探测仪器灵敏度、 精确度和易用度的不断提升, 光谱技术已经深入到各行各业的物质成分的鉴定与分析中。 对于空间目标的光谱观测是传统光学观测的重要拓展之一, 因其具有的非接触、 无损伤等优点而备受关注, 然而由于观测条件所限, 空间目标的光谱数据量极小, 通过传统方法对其进行分类分析达不到较好效果, 必须探求提高分类精度的方法。 首先, 通过1.2 m空间目标光学望远镜上搭载的光谱相机终端获取空间目标高光谱图像; 再通过天文学测光IRAF方法, 提取空间目标的一维光谱数据; 为对空间目标光谱进行分类, 提出一种结合多种深度学习方法解决小样本数据量的空间目标分类问题。 该方法应用密度聚类方法将空间目标粗糙分类, 一维生成对抗网络方法增加空间目标数据, 一维卷积神经网络方法将空间目标精细分类, 三者组合进而达到较好的实验效果, 整体精度约为79.1%(基于密度聚类、 过采样、 一维卷积神经网络方法组合、 基于K-means、 一维生成对抗网络、 一维卷积神经网络方法组合和基于K-means、 过采样、 一维卷积神经网络方法组合的整体精度分别约为78.4%, 77.9%和77.2%)。 粗糙分类模型中, 密度聚类方法比K-means方法整体精度平均高出约为0.67%; 数据增广模型中, 一维生成对抗网络方法比过采样方法整体精度平均高出约为1.52%; 精细分类模型中, 一维卷积神经网络方法二层网络比三层网络整体精度平均仅高出约为0.003%, 但是运算时间更长。 四种组合方法精度均高于单一方法。 实验结果表明本文提出的组合方法在小样本空间目标类别未知情况下, 可实现细分类且精度较高, 为实现空间目标极小数据量下的图谱一体化分析, 提供一定参考价值。

With the continuous improvement of the sensitivity, accuracy and easy use of spectral detection instruments in recent years, spectral technology has penetrated the identification and analysis of material components in all walks of life. Spectral observation of space targets is one of the important extensions of traditional optical observations. It has attracted much attention due to its non-contact and damage-free advantages. However, due to the limited observation conditions, the amount of spectral data of space targets is minimal. Traditional methods cannot achieve better results in classification analysis. In this paper, Firstly, the hyperspectral image of the space target is obtained through the spectroscopic camera terminal mounted on the 1.2 m space target optical telescope; Secondly, the one-dimensional spectral data of the space target is extracted through the astronomical photometric IRAF method; Finally, the combination of multiple deep learning methods, classify the spectral data of space targets. Accordingly, this paper proposes a combination of multiple deep learning methods to solve small sample data's spatial object classification problem. This method uses Density Clustering method to roughly classify spatial targets, one-dimensional Generative Adversarial Network method to generate spatial target data, one-dimensional Convolutional Neural Network method to finely classify spatial targets, the combination of three methods can achieve relatively good experimental results and overall accuracy is about 79.1% (Based on the combination of Density Clustering, Oversampling, one-dimensional Convolutional Neural Network methods; Based on the combination of K-means, one-dimensional Generative Adversarial Network, one-dimensional Convolutional Neural Network methods; Based on the combination of K-means, Oversampling, One-dimensional Convolutional Neural Network methods, the overall accuracy is about 78.4%, 77.9%, 77.2%). In the rough classification model, the overall accuracy of the Density Clustering method is about 0.67% higher than the K-means method; In the data augmentation model, the overall accuracy of the one-dimensional Generative Adversarial Network method is about 1.52% higher than the Oversampling method; In the fine classification model, the two-layer network of the one-dimensional Convolutional Neural Network method has an average accuracy of only about 0.003% higher than the three-layer network, but the calculation time is longer. The accuracy of the four combined methods are higher than the single method. The experimental results show that the combination method proposed in this paper can achieve fine classification and high accuracy when the small sample space target category is unknown. It provides a certain reference value for realizing the integrated analysis of the map under the minimal data volume of the space target.

近年来, 由于全球空间安全和环境监测的迫切需求, 空间目标的观测设备研制和数据分析已成为国防和科研领域的热点课题。 光谱观测因其非接触、 无损伤、 准确快速等优点而受到关注。 目前多种方法(如单狭缝光栅光谱仪、 滤光片选通分时多色测光等)均能得到质量较好的数据, 但因观测条件所限, 光谱数据的样本通常极小。

深度学习方法随着人工智能领域的飞速发展, 已逐渐成为数据分析的热门领域。 采用深度学习方法解决了大量人工无法完成的工作, 例如极小样本(有限数量的样本)和高维度分析。 本工作将多种深度学习方法(密度聚类、 一维生成对抗网络、 一维卷积神经网络)组合, 应用于小样本空间目标的光谱数据中, 有效地提高了观测数据的利用率, 扩展了数据的应用范围, 有利于对空间目标光谱数据进行深度挖掘。

Kim等[1]采用改进最远优先聚类算法对公开的真实结肠癌、 乳腺癌、 前列腺癌和淋巴瘤癌微阵列数据集进行元分类实验证实, 该方法优于单个个体分类器和其他替代方法。 本刊36卷5期刊登了马啸等提出了在小样本数据集条件下道路沥青针入度的光谱定量分析新方法: 由Bootstrap重抽样、 噪声注入及SVM组成的Bootstrap-SVM模型算法。 该方法预测精度相比PLS、 SVM预测均方根误差小。 38卷8期报道了稀疏线性判别分析(SLDA)加入正则项的机器学习算法, 同时完成分类器训练过程与变量选择过程, 判断不同方向上载荷系数稀疏性, 得出最优参数空间, 增强了模型的可读性。 将此方法应用到不同产地的秦艽样本中, 对三种秦艽样本的傅里叶红外谱进行分析预测, 其产地分类准确率达到100%。 39卷3期有文章报道基于深度信念网络Dropout的随机丢弃策略对五代时期耀州窑古陶瓷进行断代分类。 首先, 采用两层受限玻尔兹曼机(RBM)进行降维, 进而提取光谱数据高层特征, 降低特征间的相关性; 然后, 对深度信念网络进行微调, 进而提升网络训练的主动性; 最后, 在深度信念网络训练阶段, 应用Dropout随机丢弃策略, 减少网络训练过程中特征之间的依赖性。 姚燕等[2]提出遗传算法(GA)和支持向量机(SVM)相结合的全谱区范围内小样本数据的BMP快速预测方法, 该方法具有良好的鲁棒性和全局搜索能力且方法简单, 避开了传统过程中从归纳到演绎的时间浪费并剔除了样本中的大量冗余信息。

本工作将小样本空间目标光谱作为实验数据, 首先, 应用粗糙分类模型(密度聚类、 K-means方法), 分别将数据初次分类, 找出数量最少一类; 其次, 应用数据增广模型(一维生成对抗网络、 过采样方法), 分别扩充最少一类数量; 最后, 应用精细分类模型(一维卷积神经网络方法), 分别检验密度聚类和一维生成对抗网络、 K-means和一维生成对抗网络、 密度聚类和过采样、 K-means和过采样, 四种组合方法的整体分类精度, 分别约为79.1%, 78.4%, 77.9%和77.2%。 实验结果显示密度聚类、 一维生成对抗网络、 一维卷积神经网络方法, 在小样本空间目标光谱数据未知类别时, 取得了较好的分类效果, 可为空间目标高光谱图像和光谱数据一体化分析, 提供一定的参考价值。

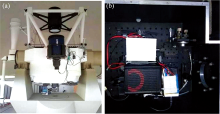

观测地点为吉林省吉林市大绥河镇, 该地有较好的空间目标观测环境。 利用1.2 m光学望远镜的卡塞格林焦点作为工作焦点, 并配有独立的导星镜, 如图1(a)所示。 终端设备为sCMOS相机、 液晶可调滤光器(LCTF)、 自制恒温器, 如图1(b)所示。 经过30 m有源Hub, 将终端设备与控制室相连, 以便随时监控望远镜状况。

选取高轨道目标作为观测对象, 以便调整终端参数并实现多圈次的观测。 选取相近天区, 尽可能减少因观测环境、 人为因素带来的影响。 观测范围为可见光波段400~720 nm, 每间隔5 nm采集一次。 光谱相机记录不同波段处空间目标的成像信息, 某空间目标在400, 435, 475, 515, 555, 595, 635, 675和720 nm波长处的图像, 如图2所示。

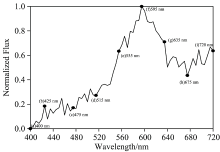

空间目标在400~720 nm波长范围的光谱, 通过天文孔径测光方法IRAF(image reduction and analysis facility)以及相关任务包, 自动提取, 并绘制成一维谱线, 通过最大最小值归一化方法

由于空间目标的光谱数据, 没有专门的类型模板库, 因此, 需要粗分类方法进行初次区分, 进而得到细分类模板。 各种聚类算法中, 密度聚类与K-means方法均有较好的效果[3], 容易实现且结果较好。

密度聚类算法[4](density-based spatial clustering of applications with noise, DBSCAN)是将样本之间分布的紧密程度作为依据来构建框架, 从密度层面的可连接性出发形成聚类族群, 即计算点与点之间的欧式距离和点密度情况, 来划分相似度较高的不同簇。 例如空间目标α 处于某域中, 其领域半径为Eps, 根据另一空间目标距α 的欧氏距离

将183个空间目标光谱随机排列, 基于密度聚类方法进行粗分类, 实验结果如表1所示。

| 表1 基于密度聚类算法进行粗分类结果 Table 1 Rough classification results based on DBSCAN |

K-means算法[5]在给定K值和K个初始类簇中心点的情况下, 把每个点(亦即数据记录)分到离其最近的类簇中心点所代表的类簇中, 所有点分配完毕之后, 根据一个类簇内的所有点重新计算该类簇的中心点(取平均值), 然后再迭代更新分配点和类簇中心点, 直至类簇中心点的变化很小, 或者达到指定的迭代次数。

将183个空间目标光谱随机排列, 采用基于K-means方法进行粗分类, 实验结果如表2所示。

| 表2 基于K-means算法进行粗分类结果 Table 2 Rough classification results based on K-means |

深度学习中, 数据增广方法是应对不平衡训练集的常用方法[6]。 其中, 生成对抗网络与过采样方法均有较好效果, 容易实现且结果较好。

生成对抗网络[7](generative adversarial networks, GAN)是2014年提出的一种可微生成式网络模型方法。 GAN可通过梯度下降法学习, 适用于零和博弈[8]的网络场景即生成器(generator)网络与判别器(discriminator)网络处于一种竞争对手模式。 生成器直接生成样本数据

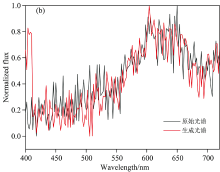

真实数据与生成数据相似度, 采用数据欧式距离进行判断, 选择Six类中某空间目标原始与生成图谱, 如图5(b)所示, 其相似度较高。

过采样(Over-sampling)[9]是一种平衡训练集的简单方法, 这意味着要反复采样训练集中比例相对较低的少数群体, 因此过采样不能有效避免训练的过度拟合。

经典的CNN主要由卷积层、 最大池化层和全连接层组成, 其中, LeNet更为经典[10]。 本工作应用的一维(1D)卷积神经网络(CNN)[11]类似LeNet作为光谱分类器。 为了适应1D光谱数据的特殊性, 我们使用了不同的网络层数, 两层和三层进行实验比较。 1D CNN基本流程图, 如图6所示。

输入层为1× 320个核执行卷积运算以生成m个特征, 见式(1)

式(1)中, 权重矩阵为$ω^{(m)}$, 偏差向量为$b^{(m)}$, σ(·)为Relu激活函数, 其式为

式(2)中, q, r∈ (2i, 2j), (2i+1, 2j), (2i.2j+1), (2i+1, 2j+1)。

在两个卷积和两个最大池化层之后, 所有特征被重新整形为一维向量f, 并被传输到MLP全连接网络, 见式(3)

式(3)中, 失调为bc, 权重矩阵为ω 。 然后利用SoftMax函数计算频谱的分类概率, 见式(4)

输出的是一维向量, 表示空间目标的光谱类别, 分别为One, Two, Three, Four, Five和Six。

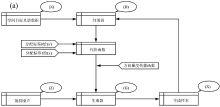

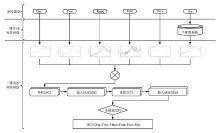

实验数据为通过光谱相机采集到的183个空间目标光谱数据, 随机排序整合为χ ; 首先, 通过密度聚类和K-means将χ 粗分为6类; 其次, 通过一维生成对抗网络和过采样增加最少一类的数据量; 最后, 通过一维卷积神经网络将χ 细分类为6类, 判断其精准度。 实验算法基本流程如图7所示。

实验一为密度聚类、 一维生成对抗网络、 一维卷积神经网络三种方法组合(DBGANCNN); 实验二为K-means、 一维生成对抗网络、 一维卷积神经网络三种方法组合(KMGANCNN); 实验三为密度聚类、 过采样、 一维卷积神经网络三种方法组合(DBOSCNN); 实验四为K-means、 过采样、 一维卷积神经网络三种方法组合(KMOSCNN)。 四种实验方法6类分类精度结果, 如表3所示。

| 表3 多种方法组合实验6类分类精度(%) Table 3 Classification accuracies (%) of six categories by using multiple methods combination |

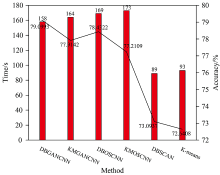

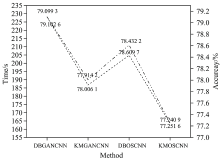

上述各个算法比较, 在同一类模型(如粗糙或精细分类模型)中, 固定数据增广模型, 分析不同方法对精度的影响; 在数据增广模型中, 固定粗分类模型, 分析不同方法对精度的影响。 影响精度值非常相近, 说明两两对比效果显著, 有助于实验对比, 得出最后结果。 各种方法平均运算时间与精度比较, 如图8所示。

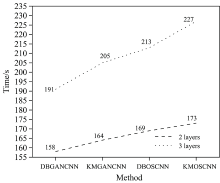

两个卷积和两个最大池化层、 三个卷积和三个最大池化层相比精度相差较小, 但计算时间更长, 所以1D-CNN选择两层结构式, 四种组合方法运算时间与精度, 如图9所示。

由以上实验结果可以看出, DBGANCNN方法在6类以及整体分类精度均高于其他方法, 为0.667 1%~1.85%, 且四种组合方法中DBGANCNN方法的运算时间比其他方法大约少6~15 s; DBGANCNN方法精度比DBOSCNN高0.667 1%, 原因在于过采样方法导致过拟合状态, 同理KMGANCNN方法精度高于KMOSCNN方法0.673 3%; DBGANCNN方法精度高于KMGANCNN方法1.85%, 原因在于K-means方法相比DBSCAN方法在粗分类上, 需要提前设定类数, 同理DBOSCNN方法精度高于KMOSCNN方法1.191 3%; 四种组合方法的分类精度均高于单一方法, 但是平均运算时间均低于单一方法; 1D CNN方法网络层数对分类精度影响较小, 2层网络与3层网络精度差距极小, 但平均运算时间更长。

空间目标光谱数据包含丰富的信息, 但由于其数据量较小无法详细分析。 基于小样本空间目标光谱数据, 应用粗糙分类模型, 密度聚类方法粗分6类获得数据类型模板; 应用数据增广模型, 一维生成对抗网络方法增加最少一类数据平衡数据集; 应用精细分类模型, 一维卷积神经网络方法实现比较准确分类。 通过光谱数据将空间目标进行分类, 应用所研究密度聚类、 一维生成对抗网络、 一维卷积神经网络组合方法分类精度较高, 进而实现未来高光谱图像与光谱数据联合分析。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|