作者简介: 许学斌, 1974年生, 陕西省网络数据分析与智能处理重点实验室硕士生导师 e-mail: ccp9999@126.com

生物特征识别在信息安全领域发挥着重要作用, 掌纹识别作为一种新型生物特征识别方式, 具有低失真、 非侵入性和高唯一性等优势。 传统掌纹研究大多使用自然光成像系统以灰度格式获取, 识别精度很难进一步提升。 为了获得更多的身份鉴别信息, 提出利用多光谱掌纹图像代替自然光掌纹图像。 针对现有掌纹识别算法由于没有考虑到不同光谱的特性而导致纹理细节丢失, 识别精准率低的问题, 提出了一种基于多光谱图像融合的掌纹识别算法。 该方法通过对不同光谱下的掌纹图像进行快速自适应二维经验模式分解(FABEMD), 将多光谱掌纹图像分解成一系列频率由高到低的二维固有模态函数(BIMF)和一个残余分量, 残余分量可被视为该光谱图像低频信息的初步估计。 图像采集过程中光照条件很难保持稳定, 而近红外光谱图像在进行FABEMD分解时对光照变换敏感, 容易导致分解后的BIMF背景信息过于冗余; 因此对分解后的近红外掌纹图像进行背景重建及特征细化, 在对背景冗余信息进行平滑处理的同时可以有效增强高频信息的特征表达。 为避免直接融合处理后引发的图像过度曝光问题, 提出对近红外特征压缩后再融合。 此外, 提出了一种结合了注意力机制的改进残差网络(IRCANet), 用于融合后的掌纹图像分类, 在网络中引入分阶段残差结构, 缓解了网络的退化问题, 在学习过程中有效地减少信息丢失, 对于融合后的多光谱掌纹图像, 分阶段残差结构能够稳定地将图像信息在网络间传输, 但对图像中的高低频信息区分效果不够显著, 为了使网络关注更多区分性特征, 利用特征通道间的相互依赖性, 在分阶段残差结构中结合了通道注意力(Channel Attention)机制。 最终, 在香港理工大学(PolyU)多光谱掌纹数据集上进行的综合实验表明, 该方法可以取得良好的效果, 算法识别准确率能达到99.67%且具有良好的实时性。

Biometric identification plays an important role in the field of information security. As a new biometric identification method, Palmprint identification has the advantages of low distortion, non-invasiveness and high uniqueness. Traditional palmprint research mostly uses natural light imaging systems to acquire in grayscale format, and it is not easy to improve the recognition accuracy further. In order to obtain more identification information, a multispectral palmprint image is proposed to replace the natural light palmprint image. Aiming at the problem that the existing palmprint recognition algorithms do not consider the characteristics of different spectra, resulting in loss of texture details and low recognition accuracy, a palmprint recognition algorithm based on multi-spectral image fusion is proposed. This method decomposes the multispectral palmprint image into a series of two-dimensional intrinsic mode functions (BIMF) with frequencies from high to low and a Residual component, which can be regarded as a preliminary estimate of the low-frequency information of the spectral image. Since the illumination conditions are unstable during the image acquisition process, and the near-infrared spectral image is sensitive to illumination transformation during FABEMD decomposition, it is easy to cause the decomposed BIMF background information to be too redundant. Therefore, the background reconstruction of the decomposed near-infrared palmprint image is performed. And feature refinement, which effectively enhances the feature expression of high-frequency information while smoothing the background redundant information. In order to avoid the problem of image overexposure caused by the spectral information after direct fusion processing, it is proposed to compress the near-infrared features before fusion. In addition, an improved residual network (IRCANet) combined with an attention mechanism is proposed for palmprint image classification after fusion, and a staged residual structure is introduced into the network to alleviate the degradation problem of the network. For the fused multispectral palmprint image, the staged residual structure can stably transmit image information between networks, but the effect of distinguishing high and low-frequency information in the image is not significant enough. In order to make the network pay attention to More discriminative features, use the interdependence between feature channels and incorporate a channel attention mechanism in the staged residual structure. Finally, comprehensive experiments on the multispectral palmprint dataset of the Hong Kong Polytechnic University (PolyU) show that the method can achieve good results, and the algorithm recognition accuracy can reach 99.67% and has good real-time performance.

生物特征识别在现代信息社会中扮演着越来越重要的角色[1]。 掌纹作为一种新兴的生物特征, 具有识别率高、 用户友好性优秀、 稳定性强等显著优点, 被认为是最有效的身份鉴别方案之一[2]。 掌纹识别[3]是基于手掌信息(包括主线、 皱纹和细纹)来验证一个人的身份, 传统掌纹识别方法主要从单一的光谱波段获取特征, 无法获得足够的身份鉴别信息。 多光谱掌纹图像利用不同波长的光谱对皮肤的吸收和反射率不同, 捕获每个波段中特定和互补的掌纹特征, 从而有效地提升掌纹识别效果。 在最近的研究中, 使用多光谱掌纹图像而非利用单个光谱图像来提高掌纹识别系统的准确性是一种日益增长的趋势[4, 5]。

多光谱掌纹识别技术主要集中在两个方向, 即在像素级和匹配分数级融合多光谱信息。 对于像素级融合, 基本思想是在一定的尺度空间上提取掌纹图像的显著特征, 再将其集成在一起, 最后通过执行逆变换重构要识别的融合图像。 研究主要集中在基于金字塔和基于小波变换。 Hao等[6]对小波变换、 梯度金字塔、 形态金字塔和Curvelet变换四种融合方案进行比较, 分别在可见光和近红外掌纹图像的两个不同光谱带上进行了评估。 此外, 其他一些创新方法, 如非采样轮廓波变换(NSCT)、 离散小波变换(DWT)、 平移不变数字小波变换(SIDWT)和数字剪切波变换(DST)在多光谱掌纹图像融合中得到了广泛和成功的应用, Meng[7]等提出利用梯度下降的同时增强融合图像分辨率, 效果显著。 在匹配分数级融合的情况下, 分别从不同的光谱带提取掌纹特征, 然后使用比较器获得匹配分数。 这些匹配分数依次使用求和规则进行融合, 然后对融合结果进行验证。 例如, Xu等[8]提出了主成分分析(QPCA)方法来分析在四个不同光谱波段采集的掌纹图像, 使用加权和规则在四个不同等级之间进行比较分数级融合, 与单个等级相比, 加权和规则表现出更好的性能。 Khan等[9]在执行匹配分数级融合之前, 将轮廓代码(CC)应用于多光谱图像的表示。

在上述工作中, 像素级多光谱掌纹图像融合方案更具吸引力, 因为它可以有效地去除掌纹图像采集过程中可能存在的噪声。 在多光谱掌纹识别中, 近红外光谱下捕获的掌纹图像信息量少但较为重要, 可见光谱下更关注掌纹图像的背景信息。 近红外和可见光谱图像往往具有较低的相关性, 因此将多光谱掌纹图像进行融合的可靠方法是将近红外光谱下处理后的显著特征与可见光谱下提取到的特征进行融合。

提出了一种基于多尺度分解的多光谱掌纹图像识别算法。 首先, 将快速自适应二维经验模式分解(FABEMD)分别应用在不同光谱的掌纹图像上提取显著特征。 其次, 考虑到近红外光谱图像的特征, 通过Bezier插值对图像进行背景重建, 再利用光谱间差异估计可能的近红外背景细化红外特征。 再次, 考虑到直接对图像进行加权融合可能会产生过度曝光的问题, 提出对近红外特征压缩后再加权融合, 使融合图像包含足够的身份鉴别信息。 最终, 为了提高识别精度降低计算成本, 提出了一种结合了注意力机制的改进残差网络对融合图像进行分类。

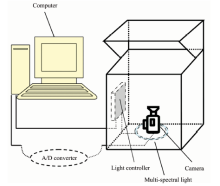

数据集来源于香港理工大学生物特征识别研究中心[10], 多光谱掌纹采集设备结构如图1, 由CCD摄像机(灵敏度: 1 Lux)、 镜头(焦距: 3.6 mm)、 A/D转换器、 多光谱光源和光控制器组成。 该设备可以捕获分辨率为352× 288或704× 576的掌纹图像。 在采集过程中, 用户需要将手掌放在设备面板上, 通过面板上的控制点固定手掌。 由于连续灯光间切换时间非常短, 设备可以在一秒内采集四种光谱下的掌纹图像。 两幅图像之间的平移或旋转非常小, 因此图像融合时不再需要配准。

从采集的图像中提取感兴趣区域(ROI)是多光谱掌纹识别的关键步骤, ROI是后续图像处理的根本运算区域。 采用基于最大内切圆法的分割方法[11], 如图2所示, 在对掌纹图像二值化后, 以手掌外侧轮廓作为定位参考线, 以手掌上最大内切圆的圆心为原点来构建掌纹图像坐标系, 裁剪内接正方形即掌纹ROI。 图2(d)为分割后近红外光谱下的掌纹ROI, 大小为128× 128。 这种分割方法能有效地增强掌纹图像中主线和褶皱线的对比度, 降低掌纹采集时旋转和平移的影响。

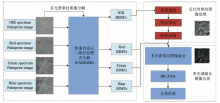

图3为所提出的基于多尺度分解的多光谱掌纹图像识别算法流程, 该算法主要包括四个步骤, 首先多光谱掌纹图像执行快速自适应二维经验模式分解(FABEMD)。 其次, 对近红外光谱下分解后的二维固有模态函数(BIMF)通过Bezier插值重建背景, 利用光谱特性差异预估可能的背景从而对显著特征进行细化。 再次, 为避免各光谱特征直接融合产生过度曝光的问题对近红外特征进行压缩后加权融合。 最终, 利用结合了注意力机制的改进残差网络对多光谱掌纹融合图像进行分类。

1.2.1 快速自适应二维经验模态分解

快速自适应二维经验模式分解(FABEMD)是一种新型信号自适应处理工具[12, 13], 目的是将信号分解成一系列频率由高到低的二维固有模态函数(BIMF)和一个残余分量。 FABEMD算法采用顺序统计滤波器和平滑滤波器生成上下包络曲面, 其中滤波器大小由数据推导而来, BIMF的生成基于迭代筛选。 令源信号为I, BIMF为S, 残余量为R, 2D信号I分解过程可由式(1)表示

$\text{I}=\overset{K}{\mathop{\underset{i=1}{\mathop \sum }\,}}\,{{S}_{i}}+R$(1)

FABEMD具体分解步骤如下:

Step1: 设置i=1并初始化J1=I。

Step2: 如图4所示, 利用相邻窗口搜索策略识别出局部极大值矩阵Mi和局部极小值矩阵Ni。 如果一个数据点的值高于或低于邻域窗口内的所有值, 则该数据点被视为局部极值。 需要注意的是, 在边界或角点处寻找极值点时, 一般忽略图像外的邻域。 通常, 3× 3是最佳窗口大小。

| 图4 局部极大极小映射 (a): 源信号矩阵; (b): 局部最大值矩阵; (c): 局部最小值矩阵Fig.4 Mapping of local maxima and local minima (a): Source signal; (b): Local maxima map; (c): Local minima map |

Step3: 根据局部极值Mi和Ni确定统计排序滤波器的最佳窗口大小, 对每个局部极大值Mi计算到其他局部极大值的欧式距离, 并将其存储在数组dadj-max中。 同样地, 向量组dadj-min也是这样计算的。 其中数组大小与极值数量相同。 考虑到窗口形状, 统计排序滤波器总的窗口尺寸取决于式(2)— 式(4)四种方式

最终窗口大小Wen是对Wen-g奇数取整, 多光谱掌纹图像的中窗口范围为3~69。

Step4: 首先, 将窗口大小为wen× wen的max和min滤波器根据式(6)和式(7)生成上下包络。

其中, zmn是大小为wen× wen的方形区域, 中心为矩阵Ji中点(m, n), UEi(m, n)为区域zmn中的最大值, 即点(m, n)的上包络值。 同理, LEi(m, n)为点(m, n)在zmn区域的最小值, 即点(m, n)的下包络值。 为了获得上下包络线的光滑连续曲面, 对UEi(m, n)和LEi(m, n)进行平滑操作

${{U}_{Ei}}\left( \text{m},\text{n} \right)=\frac{1}{{{w}_{en}}\times {{w}_{en}}}\underset{\left( s,t \right)\in {{z}_{mn}}}{\mathop \sum }\,{{U}_{Ei}}\left( s,t \right)$(8)

${{L}_{Ei}}\left( m,n \right)=\frac{1}{{{w}_{en}}\times {{w}_{en}}}\underset{\left( s,t \right)\in {{z}_{mn}}}{\mathop \sum }\,{{L}_{Ei}}\left( s,t \right)$(9)

Step5: 通过Si=(UEi+LEi)/2计算第i个BIMF。 令i=i+1, Ji=Ji-1-Si-s, 重复Step2至Step5, 直至分解的BIMF个数为k, 停止分解。

基于上述步骤, 2D信号I被分解为k个BIMF再根据式(1)计算剩余残量R。 图5为绿色光谱下的掌纹图像通过FABEMD算法分解的结果, 可以看出分解后的BIMFs包含稳定的掌纹特征, 其中图5 (g)是对k个BIMFs求和得到的特征显著的图像。

1.2.2 近红外背景重建及特征细化

在实际应用中, 多光谱图像采集过程并不像图1中描述的那样受到限制, 并且采集过程中光照条件不稳定, 而近红外光谱图像在进行FABEMD分解时对光照变换非常敏感, 容易导致分解后的BIMF背景信息过于冗余。 由此, 对近红外光谱分解求和后的显著图像重建背景, 通过平滑背景来解决近红外光谱图像背景信息过于冗杂的问题。

形态学算子和Bezier插值是两种应用广泛的背景重建技术。 形态学开放算子可以有效地估计红外背景, 但估计的背景往往会产生遮挡伪影, 影响融合后图像识别准确性。 而Bezier插值可以生成一个平滑的凸背景, 该背景与实际背景非常相似且能有效剔除冗余背景。 因此, 采用Bezier插值算法来重建近红外背景。 Bezier插值是通过插值一些已知的控制点来恢复大规模矩阵的算法, 这些控制点可以自适应地估计图像背景。 为了准确地重建红外背景, 在近红外掌纹图像中均匀采样九个控制点, 并插值重建Bezier曲面如式(10)

式(10)中, (m, n)为插值点, 其位置由0和1之间的插值比表示。 SI为插值点(m, n)的特征矩阵。 P表示常量插值系数矩阵

相较于其他光谱, 近红外光谱下的掌纹图像包含的特征对后续身份识别影响较大。 通过对数据集分析处理, 发现近红外光谱下掌纹图像平均灰度值均大于其他光谱, 且与绿色光谱下的掌纹图像平均灰度值差异最大。 因此, 利用插值后近红外图像与通过FABEMD算法分解后的绿色光谱图像灰度差异的正部分来估计可能的近红外背景区域, 并对估计的背景乘以适当的抑制比来进一步细化红外特征。

如图6所示, S'I是最终处理后的近红外光谱下的特征图像,

1.2.3 多光谱掌纹图像融合

直接融合所有多光谱掌纹图像有时会产生过度曝光, 如图7(a)所示, 融合图像上的曝光点会影响后续身份识别, 为避免产生这一问题, 对处理后的近红外光谱掌纹特征进一步压缩。

$S{{\prime\prime }_{I}}=\beta \times S{{'}_{I}}$(12)

| 图7 多光谱掌纹融合图像 (a): 未经过特征压缩的融合图像; (b): 经过特征压缩的融合图像Fig.7 Multispectral palmprint fusion image (a): Fused images without feature compression; (b): Fused images with feature compression |

式(12)中, S″I为近红外光谱下压缩后的掌纹特征, β 为特征压缩比, 取融合后图像曝光度为前1%的平均值Avg1来泛化整体融合后图像的过度曝光程度。

至此, 将所有光谱下处理后的掌纹图像通过式(14)进行融合。

式(14)中, SR, SG和SB分别为在红、 绿、 蓝三色光谱下经过FABEMD算法分解求和的掌纹图像, S″I为经过特征压缩后的近红外光谱的掌纹图像, μ 为红、 绿、 蓝三色光谱在融合时的权重, 将μ 设置为0.2, Tj为最终融合了各个光谱的掌纹图像, 如图8所示。

1.2.4 结合了注意力机制的改进残差网络(IRCANet)

随着卷积神经网络不断深入, 由梯度爆炸和梯度弥散引起的网络退化问题使得学习难度不断增加。 ResNet[14]利用残差块作为网络基本单元, 引入恒等映射来缓解这一问题。 然而, 简单地叠加残差块以构建更深的网络很难获得更好地改进, 并且残差网络平等地对待每个通道特征, 缺乏跨特征通道的学习能力, 对融合后的多光谱掌纹图像中的高低频信息不能有效区分, 从而影响最终身份识别效果。 为了解决这些问题, 提出了一种基于通道注意力机制的改进残差网络(IRCANet)。

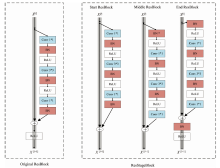

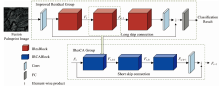

图9显示了本文所提出的IRCANet整体网络架构, 它主要包括三个部分: 在卷积层对浅层特征进行提取, 再继续输入结合了注意力机制的改进残差模块(IRG)模块中提取有区分度的高频显著特征, 最终通过全连接层进行分类识别。

| 图9 结合了注意力机制的改进残差网络的架构Fig.9 Network architecture of improved residual channel attention network (IRCANet) |

首先, 利用一个卷积层(Conv)从融合后的掌纹图像T中提取出浅层特征T0, 如式(15)

在网络训练初期, 考虑到传统残差模块主传播路径的ReLU函数可能通过将信号归零的方式对信息在网络间的传播产生负面影响, 如图10(a)。 直接允许信号以不受控制的方式通过网络会使完整信号变得非标准化, 导致网络在后期训练困难。

由此, 引入了一种分阶段残差结构(ResStage Block), 为信息传播提供了更好的路径, 如图10(b); 首先在每个阶段连接处引入批量归一化(BN)模块, 使信号稳定地进入下一阶段传播。 其次, 通过固定主路经上的ReLU函数数量, 避免在网络加深时信号传输受阻。 这种新的分阶段学习残差结构相较于传统残差块堆叠的结构, 能够有效缓解网络的退化问题, 在学习过程中减少信息丢失, 促进了信息在网络中的传播。

对于融合后的多光谱掌纹图像, 分阶段残差结构能够稳定地将图像信息在网络间传输, 但对图像中的高低频信息区分效果不够显著。 由此, 为了使网络关注更多区分性特征, 利用特征通道间的相互依赖性, 在改进的残差块中引入通道注意力(channel attention)机制。 如图11。 在新的残差结构中, 融合图像里的高频信息在训练过程中更容易被关注。 这种结合了注意力机制的改进残差结构能够在减少信息丢失的同时更关注通道间的特征信息, 不仅能促进信息在网络中的传播还能更进一步地增强网络的辨别能力。

由此, 将提取出的浅层特征T0输入结合了注意力机制的改进残差模块即IRG模块。

最终, 通过全连接层对输出的深层特征进行分类处理

式(17)中, UFC和UIRCAN分别表示全连接层和本文所提出的IRCANet结构, F表示网络分类结果。

对实验结果进行分析, 并评估了所提出方法的性能。 利用精准度(Accuracy)作为作评估标准, 定义如式(18)

式(18)中, NumTP+TN为正确识别的样本数, NumTP+FP+TN+FN为表示样本总数。

实验所使用的计算机配置是: 64位的Windows 10操作系统, 仿真软件采用MATLAB 2020a, CPU为Intel Core i7-10750H CPU, 内存64 GB, GPU 是RTX 2080 Ti。

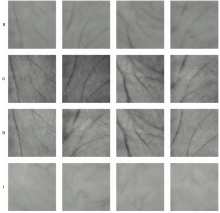

采用香港理工大学提供的PolyU多光谱掌纹数据库[8]。 图像来自20~60岁的195名男性志愿者和55名女性志愿者, 总共分两次采集, 时间间隔约9 d, 每次采集左右手掌共12张图像。 掌纹图像采集于四个光谱波段, 即红色、 绿色、 蓝色和近红外波段。 每个波段有6 000张来自500个不同手掌的图像。 图12展示了一些多光谱掌纹ROI样本。

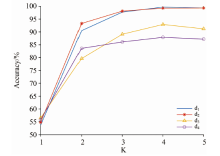

通过实验对FABEMD算法中顺序统计滤波器的窗长大小(d1, d2, d3, d4)及分解的BIMF个数进行讨论, 结果如图13所示。 为了测试BIMF数量的影响, 将分解个数K值从1逐渐增加到6, 可以观察到K值为4时并且当滤波器窗长为d1时, 效果最好。

为了获得IRCANet最优参数, 按照训练集、 测试集7∶ 3的比例随机对融合图像进行划分, 再根据所设置的参数进行不同的实验对比, 得到的结果如表1所示, 当IRCANet使用最优的参数设置时, 融合图像平均精准度最高可以达到99.67%。

| 表1 调整IRCANet参数平均准确率 Table 1 Average accuracies of different IRCANet parameters |

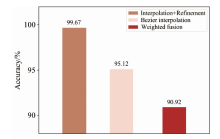

每个光谱带可以捕获一些特定的和互补的手掌特征, 为掌纹识别提供不同的信息。 近红外光谱的掌纹图像包含的特征更为显著, 对后续身份识别干扰性强。 为了验证本文所提出的对多光谱掌纹图像融合策略有效, 将近红外光谱图像处理后再融合与直接加权融合进行比较。 表2展示了三个光谱带与近红外光谱不同组合测试本文所提出的融合策略结果。 图14表示在融合所有光谱的条件下, 三种融合策略最优的识别精准度。 可以观察到, 采用直接加权的融合策略近红外与红色光谱融合效果最好, 但也仅仅达到92.04%, 对一些高精度识别很难符合要求。 在对近红外图像进行背景重建后, 融合图像识别效果显著增强, 融合所有光谱后精准度能够达到95.12%。 由此, 进一步对红外特征细化, 很明显, 对于任何融合组合, 本文所提出的对近红外特征进行背景重建及特征细化后再融合的策略效果显著, 在融合所有光谱的情况下, 识别精准度为99.67%。

| 表2 多光谱组合在不同融合策略下的精准度 Table 2 Accuracies of multispectral combinations under different fusion strategies |

| 图14 多光谱(R, G, B, N)掌纹图像在不同融合策略下最优效果Fig.14 Accuracies of different fusion strategies for multispectral (R, G, B, N) palmprint images |

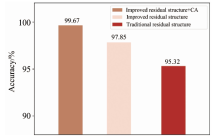

利用识别精准度作为度量对结合了注意力机制的改进残差模块、 分阶段学习残差模块和传统残差模块进行比较。 表3描述了不同光谱组合在三种残差模块下的识别精准度, 图15表示在融合所有光谱的条件下, 各残差模块最好的效果。 可以发现, 本文所提出的结合了注意力机制的改进残差模块识别精度最高。 对于任何谱带组合, 结合了注意力机制的改进残差模块对高低频信息地有效区分使得识别效果优于其他残差模块。

| 表3 多光谱组合在不同残差结构下的精准度 Table 3 Accuracies of multispectral combinations under different residual structures |

| 图15 多光谱(R, G, B, N)掌纹图像在不同残差结构下最优效果Fig.15 Optimal results of different residual structures for multispectral (R, G, B, N) palmprint images |

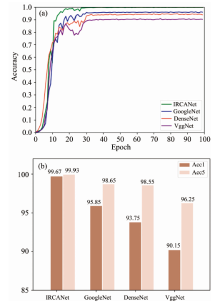

为进一步评估所提出的结合了注意力机制的改进残差网络(IRCANet), 与近年来主流网络GoogleNet[15], DenseNet[16]和VggNet[17]对融合后的多光谱掌纹图像的分类识别作比较, 从图16可以看出, 相较于其他网络, 所提出的IRCANet对融合后的多光谱掌纹图像更具有针对性, 性能更好。

| 图16 多光谱掌纹融合图像在不同主流网络下的识别效果 (a): 识别趋势; (b): 精确度对比Fig.16 Recognition effect of different mainstream networks for multispectral palmprint fusion images (a): Recognition trends; (b): Accuracy contrast |

将本算法与其他多光谱掌纹图像识别算法进行对比。 其中, 文献[18]基于小波的图像融合方法作为数据级融合策略, 采用竞争编码方案作为匹配算法, 该算法对模糊图像是有效的, 可以很好地模拟无监控的图像捕获。 文献[10]对多光谱掌纹图像的每个光谱带进行提取, 分析光谱带之间的相关性, 提出了一种分数级融合决策方案。 文献[19]提出了一种基于四元数模型的多光谱图像处理方法, 利用应用主成分分析(PCA)和离散小波变换(DWT)提取掌纹特征, 利用欧几里得距离和和最近邻分类器进行识别决策。 文献[20]提出了一种散射网络, 利用多类支持向量机和最小距离分类器进行分类。 文献[21]提出一种新的联合像素级和特征级对齐(JPFA)框架进行识别。 文献[22]提出了一种新的深度学习框架Inception-ResNet。 以上文献算法对所有光谱图像均使用单一算法, 没有考虑到近红外光谱下掌纹图像的特殊性, 在这些方法中, 所提出的算法识别精度最高, 具体对比如表4所示。

| 表4 多光谱掌纹识别算法对比 Table 4 Comparison of multispectral palmprint recognition algorithms |

为评估本算法性能, 给出了使用该算法识别多光谱掌纹图像时每个步骤的平均执行时间。 如表5所示, 本方法对于实时应用效果较好。

| 表5 本算法的时间性能 Table 5 Time cost of the proposed method |

基于多尺度变换的多光谱掌纹图像融合算法。 通过在像素级进行图像融合, 将多个光谱波段(蓝色、 绿色、 红色和近红外)的信息结合起来。 利用FABEMD在单个光谱带捕获的每幅图像分解为几个BIMF和一个残差余量。 为了保证融合空间中图像的最终识别精度尽可能高, 考虑到近红外光谱的特性, 提出对分解求和后的近红外掌纹图像利用Bezier插值背景重建及特征细化, 再将所有处理好的图像进行加权融合。 在此基础上, 利用结合了注意力机制的改进残差网络进行特征提取和分类, 引入的残差块能够在减少信息丢失的同时更关注通道间的特征信息, 能有效区分出掌纹融合图像中的高低频信息。 在PolyU多光谱掌纹数据库上进行的实验表明, 本方法可以获得非常有竞争力的结果。 此外, 在不同光照下的多光谱掌纹图像融合效果还可以进一步探索, 在光照条件比较极端时, 本算法仍有提升空间。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|