作者简介: 王翔宇, 1989年生, 长治学院电子信息与物理系讲师 e-mail: wangxiangyu8@126.com

褐斑病是黄瓜主要真菌性病害之一, 适宜条件下, 特别是在昼夜温差大及饱和湿度条件下发病迅速, 病情加重, 导致黄瓜减产, 造成经济损失。 对黄瓜褐斑病进行病斑分割与提取, 可以为后续的病害识别与诊断提供有效依据, 具有重要意义。 结合黄瓜褐斑病可见光谱图像, 利用U-net深度学习网络构建黄瓜褐斑病语义分割模型, 实现了病斑分割。 首先在采集到的黄瓜褐斑病可见光谱图像中截取病斑较为突出的区域作为样本, 共在40幅图像中截取到135个像素区域, 区域的像素分辨率为200×200, 利用Matlab的Image Labeler工具对样本进行像素标记, 分别标记出感病区域和健康区域。 然后构建U-net网络, 该网络包含46层和48个连接, 通过卷积层和线性整流层以及最大池化法来完成病斑特征提取, 通过深度连接层以及上卷积层和上线性整流层完成上采样, 通过跳层连接来完成复制和剪裁操作, 并进行病斑特征融合。 利用所构建的U-net网络进行学习训练得到语义分割模型, 在135个样本中, 随机选取其中96个作为训练样本, 剩余的39个作为测试样本, 设置迭代次数为240次, L2正则化系数为0.000 1, 初始学习率为0.05, 动量参数为0.9, 梯度阈值为0.05, 进行样本训练和测试。 经过10次重复训练和测试, 结果表明, 基于U-net和可见光谱图像的黄瓜褐斑病语义分割模型执行时间平均为46.4 s, 内存占用平均为6 665.8 MB, 执行效率较高; 模型准确率PA为96.23%~97.98%, MPA为97.28%~97.87%, MIoU为86.10%~91.59%, FWIoU为93.33%~96.19%, 模型的稳定性较好、 泛化能力较强。 该研究方法利用较少的训练样本, 获得了准确率较高的分割模型, 为小样本机器学习提供了参考, 同时为其他蔬菜的病斑分割、 病害识别与诊断提供了方法依据。

Target leaf spot is one of the main fungous diseases of cucumber. Under suitable conditions, especially under the conditions of the large temperature difference between day and night or saturated humidity, the disease develops rapidly, leads to the reduction of cucumber yield and brings economic losses. The cucumber target leaf spot segmentation can provide an effective basis for the identification and diagnosis of cucumber disease, which has great significance. In this study, a cucumber spectral image was taken as the research object, and U-net deep learning network was utilized to construct the semantic segmentation model for cucumber target leaf spot segmentation. Firstly, the regions with more prominent lesions in the visible spectrum images were selected for training and testing. We captured 135 regions out of 40 images as samples, and each region was 200×200 pixel. The Image labeler tool of Matlab was used to label the samples to mark the affected area and the healthy area. Then, the U-net network was constructed, which contains 46 layers and 48 connections. The cucumber target leaf spots’ feature extraction is completed by convolution layer, ReLU layer and max-pooling. The upsampling is completed by deep connection layer, up convolution layer and up-ReLU. The copy and crop operations and feature fusion are completed by skip connection. The U-net was used for training to get the semantic segmentation model. From 135 samples, 96 were randomly selected as training samples and the remaining 39 as test samples. Set the iterations 240, L2 regularization coefficient 0.000 1, initial learning rate 0.05, momentum parameter 0.9, gradient threshold 0.05, and then utilize the samples for training and testing. After 10 repeated training and testing, the results showed that the average execution time of the semantic segmentation model based on U-net and visible spectrum images was 46.4 s. The average memory occupation was 6 665.8 MB, and it shows that the model has a high execution efficiency. The pixel accuracy of the model was 96.23% ~ 97.98%, mean pixel accuracy was 97.28%~97.87%, mean intersection over union was 86.10%~91.59%, frequency weighted intersection over union was 93.33%~96.19%. It shows that the model has good stability and strong generalization ability. This research used less training samples to obtain a segmentation model with high accuracy, which provides a reference for small sample machine learning and provides a method basis for other vegetable disease spot segmentation, disease identification and diagnosis.

黄瓜褐斑病, 又称靶斑病(Target leaf spot), 是黄瓜主要的真菌性叶斑病之一[1]。 该病由多主棒孢霉(Corynespora cassiicola)侵染引起, 发病初期在叶面出现黄色小斑点, 中期扩大为圆形或不规则形状的褐色病斑, 后期病斑面积扩大且颜色呈灰褐色, 发病率一般为20%~40%, 严重时达60%~70%, 导致落叶率提高, 造成黄瓜大面积减产, 给农户带来巨大的经济损失[2, 3, 4]。 植物病斑的准确分割为后续的病害识别与诊断提供了有效依据, 具有重要意义。

目前的病斑分割方法主要包括数字图像处理和深度学习两种方法[5]。 数字图像处理方法众多, 已经发展成熟。 白雪冰等[6]利用小波降噪和分水岭算法提取目标叶片, 然后利用Otsu算法完成了黄瓜白粉病病斑分割。 有研究结合可见光谱图像的ExR, H和b* 三种颜色特征, 利用CVCF方法和形态学操作, 获得了黄瓜霜霉病斑的分割结果。 有报道结合黄瓜叶片FTIR光谱和聚类分析, 完成了褐斑病的检测。 深度学习方法是一种新兴的机器学习算法, 近几年才逐步应用于实践中[7, 8, 9]。 深度学习能够自动提取图像特征, 已经在图像识别[10, 11]、 故障诊断[12, 13]、 遥感[14]、 医学[15]等领域得到应用。 任守纲等[5]利用反卷积引导的VGG网络完成了番茄叶部病斑分割, 模型分割准确率达94.66%。 杨森等[16]利用Faster R卷积神经网络完成了马铃薯早疫病、 晚疫病、 炭疽病的识别, 在特定光照条件下的平均识别准确率达90.83%。 薛勇等[17]利用GoogLeNet深度迁移模型完成了苹果缺陷检测, 为苹果自动分级提供了方法。

利用数字图像处理方法完成目标分割需要人为提取大量的特征集, 当手动为一个复杂任务设计特征集时需要耗费大量的时间和精力, 而且这些特征的确定还需要依赖一定的经验, 且具有一定的不确定性, 如果特征集选取不当, 会导致图像分割结果准确度差[18]。 而深度学习, 不需要人为确定特征集, 机器可以通过自我学习来实现像素级的特征提取并完成语义分割, 对于同等复杂度的任务, 其提取特征集的效率更高, 且不依赖人为经验, 可以节约大量人力和时间[19, 20, 21]。

黄瓜常见病害中, 霜霉病、 白粉病研究最为多见, 而褐斑病研究较少。 本研究以黄瓜褐斑病可见光谱图像为研究对象, 利用U-net深度学习网络提取病斑像素特征, 完成病斑的语义分割, 为黄瓜褐斑病的识别与诊断提供了有效方法。

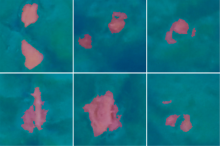

研究所使用的黄瓜褐斑病图像由天津市植物保护研究所提供, 采集设备为Canon PowerShot G15, 拍摄参数光圈值F3.2, 曝光时间1/800 s, ISO-1600, 焦距6 mm, 关闭闪光灯。 图像分辨率为2 816× 1 880像素, 位深度24 bit, 色彩标准为sRGB, 3通道。 所需图像在实验室条件下完成拍摄, 为了更加全面地获取褐斑病病斑特征, 图像采取完整叶面和局部叶面相结合、 叶正面和叶背面相结合的方法进行拍摄。 拍摄图像共计40幅, 其中包括全叶图像28幅(叶正面14幅, 叶背面14幅)和叶片局部图像12幅(叶正面7幅, 叶背面5幅)。 部分图像如图1所示。

利用U-net完成图像语义分割, 需要预先进行深度学习样本标记。 本研究采用Matlab的Image Labeler工具进行样本标记。 为便于计算机进行深度学习训练, 需对40幅黄瓜褐斑病原始图像进行预处理。 首先在原始图像中截取病斑较为突出的区域作为目标区域, 由于目标区域分辨率较大会严重影响机器学习速率, 因此目标区域的分辨率选定为200× 200像素以提高学习速率, 共在40幅原始图像中截取到135个像素区域, 将这些区域另存为JPEG格式的图像。 然后对截取到的135个图像进行图像像素标注, 给定两个标签集合Helth_area和Affected_area。 其中, Health_area代表健康叶片区域, 用蓝色进行标注; Affected_area代表褐斑病区域, 用紫色进行标注。 标注后导出图像样本, 部分样本如图2所示。

U-net由Ronneberger等于2015在MICCAI上提出, 是深度学习网络的一种, U-net网络是对FCN网络的改进。 与FCN网络相比, U-net网络加入了跳层连接(Skip connection), 使得分割结果可以保留更多的局部细节。 U-net网络结构示意图如图3所示。

U-net网络的工作流程主要包括下采样和上采样两部分, 如图3所示, 左侧为下采样过程, 右侧为上采样过程。 U-net网络通过最大池化(Max-pooling)来增大感受视野, 提取图像最明显的特征, 即完成下采样; 通过上卷积(Up-convolution)来使图像进行由小分辨率到大分辨率的映射以恢复图像尺寸, 即完成上采样。 整个网络利用卷积(Convolution)和线性整流函数(ReLU)来完成输入图像(Input image)的采样, 并输出特征图(Output feature map)。 其中, 卷积主要完成图像局部特征的提取, 线性整流函数主要完成相关特征的保留, 并去掉不相关特征。 U-net网络中引入跳层连接(Skip connection), 可以把较浅的卷积层特征引过来, 使得网络在每一级的上采样过程中, 将编码器对应位置的特征图在通道上进行融合, 从而保证了最后恢复出来的图像融合了更多的底层特征和不同规模的特征, 使分割图像保留更多细节信息, 提高了分割精度。

构建的U-net网络如图4所示。 该U-net网络总共包含46层和48个连接。 输入层为200× 200像素的3通道可见光谱图像。 该网络通过池化操作完成下采样, 池化操作分为平均池化(Mean-pooling)和最大池化(Max-pooling)两种, 平均池化即对邻域内特征点求平均, 最大池化即对邻域内特征点取最大。 在叶片中, 由于病斑区域的像素特征与健康区域的像素特征区别较大, 为了更加显著地提取病斑特征, 采用最大池化来保留病斑区域的纹理特征。 下采样过程中, 每一级之间包括Conv-1和Conv-2两个卷积层以及ReLU-1和ReLU-2两个线性整流层, 通过卷积层来提取叶片病斑的高层次特征, 通过线性整流层来增加各层之间的非线性关系并缓解过拟合发生。 上采样通过深度连接(depth concatenation)操作完成, 上采样过程中, 每一级包括Conv-1和Conv-2两个卷积层, ReLU-1和ReLU-2两个线性整流层, 以及一个Up Conv层和一个Up ReLU层。 同一级的上采样和下采样使用跳层连接来完成复制和剪裁(Copy& Crop)操作, 将深层和浅层的特征进行融合, 使叶片病斑的分割图像更加精细, 从而获得更加准确的分割结果。

利用所构建的U-net网络进行训练得到训练模型, U-net模型具有小样本学习的优势, 能够利用更少的训练样本进行学习, 实现更快速、 更有效地分割。 训练和测试使用的样本为1.2节中所述的135个样本, 样本图像大小为200× 200像素, 3通道。 随机选取其中96个作为训练样本, 用于模型训练, 剩余的39个作为测试样本, 用于模型测试。 模型训练所使用的GPU型号为Nvidia GeForce GTX 1070, 显存8 GB, 内存带宽256.26 GB· s-1, CUDA核心1 920个, 基础频率1 506 MHz, 算力6.1。

为避免产生过学习的情况, 设置最大训练周期(max epochs)为10轮, 小批量规模(mini-batch size)为4, 则96个样本每轮迭代为24次, 共计迭代240次。 设置L2正则化系数为0.000 1, 初始学习率(initial learning rate)为0.05, 动量参数(momentum)为0.9, 梯度阈值(gradient threshold)为0.05。 设定好以上参数后, 利用U-net网络完成训练, 模型的训练时间、 准确度与损失如表1所示。

| 表1 U-net模型训练时间、 准确度与损失 Table 1 Training time, accuracy and loss of U-net |

由表1结果知, 模型训练时间较短, 仅需48 s就可以完成240次迭代, 且训练完成后, 模型的小批量准确度可达98.23%, 小批量损失为0.042 5, 模型准确度较高, 可以用于黄瓜褐斑病的病斑分割。

语义分割的评价指标主要包括执行时间、 内存占用和准确率三个指标。 为更客观地反映出分割模型的效率和泛化能力, 本研究共重复进行10次训练来统计模型的运行结果。 分割模型的执行时间和内存占用情况如表2所示。

| 表2 分割模型的执行时间和内存占用 Table 2 Execution time and memory footprint of the segmentation model |

由表2知, 分割模型的执行时间为46~48 s, 平均执行时间为46.4 s, 内存占用为6 631~6 704 MB, 平均内存占用为6 665.8 MB。 模型的执行时间较短, 占用内存较少, 执行效率较高。

除了执行时间和内存占用两个评价指标外, 本研究还利用4种语义分割准确率评价指标进行了分割模型的评价。 这4种准确率评价指标分别为PA(pixel accuracy, 像素准确率)、 MPA(mean pixel accuracy, 平均像素准确率)、 MIoU(mean intersection over union, 平均交并比)和FWIoU(frequency weighted intersection over union, 频率加权交并比)。

PA为像素准确率, 即分类正确的像素点数量和所有像素点数量的比值, 见式(1)

MPA为平均像素准确率, 即每一类分类正确的像素点数量和该类的所有像素点数量的比值的均值, 见式(2)

MIoU为平均交并比, 即每一类的IoU的均值, 见式(3)

FWIoU为频率加权交并比, 即根据每一类出现的频率对各个类的IoU进行加权求和, 见式(4)

式(1)— 式(4)中, pii表示本属于i类且预测为i类的像素点总数; pij表示本属于i类却预测为j类的像素点总数; pji表示本属于j类却预测为i类的像素点总数。

本研究重复进行10次训练, 得到的模型准确率统计结果如表3所示。

| 表3 分割模型的准确率评价 Table 3 Accuracy of the segmentation model |

由表3知, 经过10次重复训练, 模型的像素准确率PA为96.23%~97.98%, 平均像素准确率MPA为97.28%~97.87%, 平均交并比MIoU为86.10%~91.59%, 频率加权交并比FWIoU为93.33%~96.19%, 可知模型的稳定性较好、 泛化能力较强。

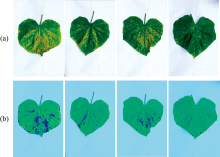

通过综合比较10次训练结果, 第6次的训练结果准确率更高, 因此将第6次训练的U-net网络结构进行存储, 以备后续直接调用。 利用训练好的模型进行黄瓜褐斑病图像分割, 结果如图5所示。

| 图5 黄瓜褐斑病分割结果 (a): 原始图像; (b): 病斑分割图像Fig.5 Segmentation results of cucumber target leaf spot (a): Original images; (b): Segmentation images of target leaf spot |

根据黄瓜褐斑病的分割结果, 可以得知本研究构建的基于U-net的病斑分割模型对于黄瓜褐斑病的分割具有较好的效果。 无论是褐斑病早期发生时的面积较小的圆形黄色病斑斑点, 还是晚期感病面积扩大后的不规则形状的褐色病斑, 该模型均能实现准确分割, 因此该分割模型可以适用于黄瓜褐斑病发生初期以及中后期, 且均能起到良好的分割效果。

利用U-net深度学习网络, 并结合黄瓜叶片可见光谱图像, 完成了黄瓜褐斑病的像素特征提取与病斑分割, 为黄瓜褐斑病的识别与诊断提供了依据。 构建U-net网络, 对标定好的黄瓜褐斑病图像样本进行学习训练, 得到分割模型, 然后利用测试样本对模型测试。 本研究经过10次重复训练和测试并综合分析, 基于U-net和可见光谱图像的黄瓜褐斑病分割模型执行时间较短, 平均46.4 s, 内存占用较少, 平均6 665.8 MB, 总体执行效率较高; 模型准确率PA为96.23%~97.98%, MPA为97.28%~97.87%, MIoU为86.10%~91.59%, FWIoU为93.33%~96.19%, 结果表明, 模型具有较好的稳定性和较强的泛化能力。 本研究通过较少的训练样本, 获得了准确率较高的分割模型, 为小样本机器学习算法提供了参考, 同时为蔬菜病害识别提供了方法依据。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|