作者简介: 沈 瑜, 女, 1982年生, 兰州交通大学电子与信息工程学院副教授 E-mail: shenyu_sy@163.com

为了对雾霾天气下的图像进行去雾处理, 多幅图像去雾算法是常用的方法之一。 多幅图像去雾算法也有多种形式, 部分算法面临硬件实现困难、 获取途径受限或者可实施性弱等问题, 而且多幅图像比对处理时常常涉及图像配准, 造成算法的实时性差、 计算复杂度高等问题。 针对以上问题, 提出的算法为多幅图像去雾提供了新的思路, 基于双目传感器硬件架构能够同时捕获近红外和可见光图像, 将近红外传感器图像作为新的数据源, 近红外传感器能够在一定程度上穿透雾霾, 在雾天捕获可见光传感器无法捕获的图像细节, 而且硬件实现简单。 可见光图像的颜色信息较丰富, 近红外传感器图像对近处场景细节的描述能力较好, 捕获的图像稍加校正就能实现完全配准, 将近红外图像与可见光图像进行融合, 在去雾的同时, 可以将近红外传感器图像中的原始细节提取融合到彩色可见光传感器图像中, 得到边缘、 轮廓等细节信息更加丰富的去雾图像。 基于上述思路, 借助近红外传感器对边缘细节的描述能力和可见光传感器对颜色信息的反映能力, 提出了一种基于近红外与可见光双通道传感器图像融合的去雾算法。 首先, 将彩色可见光图像转换到HIS彩色空间, 分别得到亮度通道图像、 色调通道图像和饱和度通道图像。 先将其亮度通道图与近红外图像进行融合去雾处理。 采用非下采样Shearlet变换(NSST)进行分解, 对得到的高频系数进行双指数边缘平滑滤波器保边滤波处理, 对低频系数进行反锐化掩蔽处理, 通过融合规则和反向变换得到新的亮度通道图像。 然后, 在对可见光图像的色彩处理中, 建立饱和度图的退化模型, 采用暗原色原理对参数进行估计, 得到估计的饱和度图。 最后, 将新的亮度通道图像, 估计的饱和度图像和原色调图像反映射到RGB空间得到去雾图像。 为了验证新算法的有效性, 特选取四组雾天拍摄的真实近红外图像与可见光图像进行融合去雾处理, 将融合结果与其他两种去雾方法对于彩色可见光图像的去雾效果进行比较。 实验结果表明, 该算法在提高图像的边缘对比度和视觉清晰度上有较好的效果。 并提出将近红外传感器图像作为新的数据源, 采用双通道图像融合方法进行去雾处理, 为图像去雾提供的新的技术思路是可行的。 该算法的优势在于: 首先提出将图像融合方法与去雾算法相结合, 得到了新的去雾算法的思路。 将彩色可见光图像转换到HSI色彩空间, 将其亮度通道图与近红外图像采用非下采样Shearlet变换方法进行融合处理, 在去雾的同时, 可以将近红外传感器图像中的原始细节提取融合到彩色可见光传感器图像中, 使得去雾图像中的边缘、 轮廓等细节信息更加丰富。 其次, 提出了在图像去雾算法中采用新的数据源——近红外传感器图像, 从图像处理的角度, 近红外传感器能够在一定程度上穿透雾霾, 对于近处场景细节的描述能力较好, 而且硬件实现简单, 捕获的图像稍加校正就能实现完全配准, 为后续的融合去雾算法带来了便利, 为图像去雾提供了新的技术途径和路线。 再次, 采用的是多幅图像去雾算法, 该算法基于双目传感器获取图像, 可见光图像的颜色信息较丰富, 近红外图像对于近处场景细节的描述能力较好, 相对于单幅图像去雾算法, 有更好的效果。 最后, 将可见光传感器图像映射到其他色彩空间, 对于每个通道的图像根据其特征有针对性地进行处理。 可见光图像的亮度通道图和近红外图像的处理采用了图像融合和增强处理, 对于可见光图像饱和度通道的处理采用了图像复原算法, 可以从整体上提升去雾效果, 对细节特征有了进一步增强。 该算法为图像去雾提供了新的技术途径和路线。

In order to defog the image under hazy weather, multiple images defogging algorithm is one of the commonly used methods. Multiple images defogging algorithm also takes many forms, some of which are usually confronted with the problems of difficult hardware implementation, limited data source achievement approaches, or poor implementation et al. Meanwhile, multiple images defogging algorithm usually needs image registration in the comparison process, causing poor real-time performance and high computation cost. For the above problems, this study supplies a new idea for multiple images defogging algorithm, the near-infrared sensor images are used as new data source. The near-infrared sensor could penetrate haze to some extent, capturing the image details that the visible light sensor could not get. Meanwhile, the hardware of dual sensor system is simple. In the dual sensor system, the visible light image has abundant color information and the near-infrared sensor image can better describe the scene details at close range. The captured images could be completely registered with little rectification. The fusion of the infrared image and visible light image could extract the image details of the near-infrared image to the color visible light image to get the defogging image with abundant edge and contour information. Therefore, this study proposed a defogging algorithm using near-infrared and visible light image fusion method based on the edge details descriptive ability of the near-infrared sensor and the expressive ability of color information. Firstly, the color visible image was transformed from RGB space to HIS color space to get the hue channel image, saturation channel image and intensity channel image. The intensity channel image and original near-infrared image were decomposed by the Non-subsampled Shearlet Transform (NSST) method to get the high frequency coefficients and the low frequency coefficients. The high frequency component was treated by the double-exponential edge smoothing filter and the low frequency component was treated by the Unsharp Masking method, then the fusion rules and the inverse NSST were adopted to get the new intensity channel image. For the color information treatment of the visible light image, the degeneration model of the saturation channel image was established and the dark channel prior was used to evaluate its parameters to get the new saturation channel image. Finally, the new intensity channel image, the new saturation channel image and the original hue channel image were inversely mapped to the RGB space to get the defogging image. In order to verify the algorithm, we adopted 4 groups of foggy near-infrared images and visible light images as the experimental data. The processed images were compared with the defogging images observed by other two defogging algorithms. The experiment results showed that the proposed algorithm has better effect in improving the edge contrast and visual clarity. This study put forward the near-infrared image as new data source and the binary channels image fusion algorithm as the defogging method, and it was verified that the new algorithm for image defogging is feasible. This algorithm has four main advantages. The first one is that we combined the image fusion method with the defogging algorithm to get a novel idea for defogging algorithm. We transformed the color visible image to HSI color space. The obtained intensity channel image and original near-infrared image were fused by the NSST method, and the image details in the near-infrared image were simultaneously extracted to the color visible image in the defogging processes. The defogged image has abundant detailed information of edge and rough. The second advantage is that this algorithm adopted near-infrared sensor image as new data source. From the perspective of image processing, the near-infrared sensor could penetrate haze to some extent, capturing the image details that the visible light sensor could not get. Meanwhile, the hardware of dual sensor system is simple. The third advantage is that we adopted multiple images defogging algorithm, which captured images by binocular sensor system, and the visible light sensor got the image with abundant color information and the near-infrared sensor got the image with good detail description ability of close shot. The fusion of the two kinds of images has better effect than the single image defogging algorithm. The fourth advantage is that the visible light image was transformed to the HIS color space, and the images of the three channels can be targetedly processed according to their data characteristics. The process of intensity channel image of visible light image and the near-infrared image adopted image fusion and enhancement methods. The process of saturation channel image of visible light image adopted image restoration method. These processing enhances the effect of defogged image on the whole. This study supplies a new technological approach and way for image defogging algorithm.

雾霾作为一种大气污染状态在全国甚至世界各地频发, 雾霾天气下空气中漂浮着水汽和气溶胶[1], 由于光线受到水雾、 悬浮物和气溶胶粒子[2]的影响会使景物光发生退化, 图像传感器在获取图像的过程中造成严重的图像降质问题[3]。 由于雾霾覆盖, 白天捕获的图像整体为灰白色, 图像对比度降低造成图像模糊、 目标无法识别, 图像质量无法满足户外监控、 卫星遥感监测、 交通运输安全的需要。 因此, 雾天图像清晰化算法的研究非常重要。

国内外有较多学者进行图像去雾算法工作的探索和研究。 从图像去雾算法的角度通常分为两种: 一是基于图像增强的方法, 直接对于图像像素在空间域进行处理, 以增强图像的对比度、 边缘的清晰化程度、 从视觉上提升图像的效果为目的; 二是基于图像复原的方法, 由于单幅图像去雾算法中往往得不到图像景深、 大气条件等辅助信息, 所以需要建立图像的大气散射退化模型, 通过成像过程的反推过程, 然后借助一定的先验知识进行原始图像的估计, 获得目标的无雾图像。 该方法实现形式相对简单, 且对硬件要求小, 最近在这方面的研究比较多。 He等[4]提出的暗通道先验模型受到研究者的好评, 成为该方面的主要研究方法。

从图像源的角度, 分为多幅图像去雾和单幅图像去雾。 利用多幅图像信息, 例如偏振图像、 晴天图像、 红外图像、 视频中的帧序列等作为辅助以达到去雾效果。 这类去雾算法需要辅助图像作为条件, 复原的效果也较好, 但辅助图像的获取也是相对复杂的。 所以由于硬件设备限制加上处理的复杂性, 当前大部分的研究都集中在单幅图像去雾上, 但也有少数学者对多幅图像去雾进行了研究。 Miyazaki等[5]提出一种基于多幅偏振图像的图像去雾算法, 利用不同极化条件下捕获的两幅图像进行去雾处理, 指出偏振镜只有在特定状态下才是有效的, 对偏振镜的操作要求严格, 不然容易造成人为失误。 Yadav[6]等捕获雾天图像序列, 通过四个步骤对雾天图像进行处理, 在对图像散射、 能见度水平进行估计的基础上, 对图像进行增强和滤波处理。 Zhang[7]等提出了基于多幅图像的大气模型去雾算法, 采用晴天图像与雾天模糊图像作参考, 较好地估计出参数值。 Jiang[8]等提出了遥感图像中的去雾方法, 对遥感图像序列选择色彩补偿图像, 图像在平均亮度值附近对于MSR进行拉伸使得图像得以增强, 然后得到新的色彩补偿图像, 去雾后的图像在信息熵上表现较好。 刘同军等[9]提出一种基于大气散射退化模型的多幅偏振图像去雾算法, 能够有效地得到清晰化的去雾图像。 李楠等[10]提出一种序列交通图像去雾方法, 建立大气退化模型, 建立距离场并对距离场的分布特征进行归一化处理, 最后优化模型参数, 得到较好的去雾效果。

通过上述分析可知, 多幅图像去雾算法有多种形式; 一种通过偏振镜得到不同极化条件下的图像进行去雾处理, 这种方法对于偏振光片依赖性强, 使用范围受限; 一种是拍摄不同空气条件下同一场景的雾天、 晴天图像进行去雾处理, 这种方法受天气和时间的约束, 实时性差, 可实施性也很弱; 还有一些情况需要不同条件下的参考图像, 这些图像在获取途径上也不容易实现。 所以多幅图像去雾算法常常面临硬件实现困难、 获取途径受限等问题, 而且多幅图像同时比对处理时还涉及图像配准的问题, 算法的实时性差、 计算复杂度高。

因此, 我们提出一种基于近红外与可见光双目图像传感器的融合去雾算法。 首先, 将可见光传感器捕获的彩色图像转换到HSI色彩空间, 为了将近红外传感器图像中的细节特征提取到可见光彩色图像中, 将可见光图像的亮度通道图与近红外传感器捕获到的图像根据非下采样Shearlet变换方法(non-subsampled Shearlet transform, NSST)进行融合处理, 通过对高通分量和高频分量的滤波和增强操作, 实现对亮度图的去雾和增强操作。 对于可见光的饱和度通道, 建立其退化模型, 采用暗原色原理估计参数, 得到去雾后的饱和度图。 最后将去雾后的亮度通道图、 饱和度通道图和原色调通道图像反向映射到RGB色彩空间, 实现了去雾处理。

本算法为多幅图像去雾提供了新的思路, 将近红外传感器图像作为新的数据源, 近红外传感器能够在一定程度上穿透雾霾, 能够在雾天捕获可见光传感器无法捕获的图像细节, 而且硬件实现简单。 基于双目传感器获取图像, 可见光图像的颜色信息较丰富, 近红外传感器图像对近处场景细节的描述能力较好, 捕获的图像稍加校正就能实现完全配准, 将近红外图像与可见光图像进行融合, 在去雾的同时, 可以将近红外图像中的原始细节提取融合到彩色可见光图像中, 使得去雾后的图像边缘、 轮廓等细节信息更加丰富。 本算法为图像去雾提供了新的技术途径和路线。

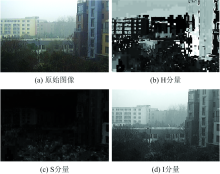

HSI是基于人眼视觉系统的颜色模型, 采用色调(Hue)H通道, 饱和度(Saturation)S通道和亮度(Intensity)I通道, 三个通道可以独立实现颜色的调整。 它与RGB颜色模型可以相互转换。 HSI模型有其独特的性质: 一是它的亮度分量与彩色信息无关, 通道相互独立, 亮度分量的单独处理不会影响图像的颜色信息; 其二, HSI颜色模型更符合人类视觉特性, 有利于图像处理。 更重要的原因是将可见光彩色RGB图像映射到HSI空间, 色调通道不会因为雾天的影响而发生降质[11], 该通道的数据不需要进行后续的去雾处理。 只需要对于亮度通道和饱和度通道分别处理, 简化了后续计算过程。

将彩色可见光图像映射到三通道之后的图像如图1所示。

非下采样Shearlet变换(NSST)是在Shearlet变换的基础上发展起来的, 是Guo等[12]由合成膨胀仿射系统构造的多尺度几何分析方法之一。 其特点是结构简单, 通过平移、 旋转、 伸缩等可以方便地生成基函数, 具有多维函数稀疏表示性能。 二维的合成膨胀仿射系统表示如式(1)

其中,

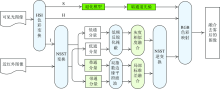

NSST是基于非下采样金字塔(non-subsampled pyramid, NSP)滤波组和剪切波滤波器组(shearlet filter, SF)两部分组成, 如图2所示。 通过NSP实现多尺度变换, 为了提取图像中的奇异性特征, 对低频系数不断进行NSP分解, k层分解会得到1个低频系数和k个高频系数。 将SF映射到笛卡尔坐标系, 通过傅里叶变换, 采用二维卷积进行滤波, 避免了下采样的操作, 使得NSST具有了平移不变性, 而且变换后的图像与源图像尺寸相同, 有利于进行图像的融合操作。

算法流程图如图3所示。

Step1 将可见光传感器捕获的彩色图像FVi转换到HIS彩色空间, 得到色调通道图像FVi, H, 饱和度通道图像FVi, S和亮度通道图像FVi, I;

Step2 将可见光图像的亮度图像与近红外图像FIn采用NSST方法进行分解, 得到分解后的高频系数

Step3 对于分解的高频系数

Step4 对于分解的低频系数

Step5 将得到的融合后的高频系数FH, F和低频系数FL, F进行NSST反向变换得到处理后的亮度通道图像

Step6 对于可见光图像的饱和度通道, 建立退化模型, 采用暗通道原理对参数进行估计, 得到估计的饱和度图

Step7 将处理后的亮度通道图像

NSST多方向多尺度分解后的高频分量, 含有图像大部分的高频边缘、 轮廓细节, 而且噪声也属于高频成分。 大部分的滤波器在滤除噪声的同时, 常常损失很多的高频边缘等线性细节。 为了对多尺度分解后的高频系数进行滤波处理, 采用双指数边缘平滑滤波器BEEPS(bi-exponential edge-preserving smoother)。 BEEPS滤波器是Philippe等[13]在2012年提出的一种保边滤波器, 它的原理类似于双边滤波器中的值域滤波, 但是摒弃了双边滤波器中的边缘梯度反转效应, 降低了计算的复杂度。 每个像素点的计算只与其上一个像素点的计算有关, 不依赖滤波参数和像素自身的灰度值。 对于包含n个元素的离散序列x[n]其一次BEEPS滤波结果

BEEPS滤波器在对二维图像进行处理时, 将其看作若干个离散序列构成的二维矩阵, 先对矩阵做先水平后垂直的BEEPS滤波, 记录滤波结果; 然后再对原始矩阵做一次先垂直后水平的滤波, 记录滤波结果; 最后取两次滤波结果的平均值, 得到最终的处理结果:

高频子带系统的融合规则是基于灰度相似度值的方法。 计算红外图像高频分量和可见光图像高频分量在p(x, y)点和q(x, y)点上的灰度差值大的作为相似度项, 见式(4)

其中, IAP-IAq表示红外图像高频分量在p(x, y)点和q(x, y)点上的灰度值差; IBP-IBq代表可见光图像高频分量在p(x, y)点和q(x, y)点上的灰度值差。

根据该融合规则, 得到高频融合系数FH, F。

NSST多尺度多方向分解后的低频分量含有图像大部分的能量, 同时低频分量受到雾的污染需要进行滤波增强处理。 采用一种改进的低频反锐化掩蔽增强算法对NSST的低频分量进行处理。

反锐化掩蔽(Unsharp Mask)将原图和模糊化的图像相加以达到图像增强的目的。 通常, 反锐化掩蔽的处理过程如下:

(1)通过模糊模板Klow对原图像进行模糊化处理, 得到图像Ilow

(2)原图像减去模糊化图像Ilow, 得到差值图像, 又称为掩模模板Imark

(3)将掩模模板与适当的系数相乘, 然后与原图像相加, 得到高频细节增强后的图像

下面将反锐化掩蔽方法进行改进, 使之适用于NSST的低频分量增强。

NSST低频图像受到薄雾干扰, 大气散射现象造成图像模糊, 边缘和细节不清楚, 图像对比度低。 建立NSST低频图像的大气散射模型

其中, d表示图像传感器到场景的距离; λ 表示光的波长; β (λ )表示大气散射系数; h0(λ )表示入射光在x=0点的辐射度。

对于图像f(x, y), 模糊化后的图像为

其中, f(x, y)代表原图像; h是使图像变模糊的等效滤波器, 这里是指上述的点扩展函数。

掩蔽模板为

低频反锐化掩蔽后的图像

对于NSST的低频系数

低频子带系数融合规则最常见的是简单的平均法, 但是它会大幅降低图像的对比度, 融合后的图像对比度低, 会损失重要特征。 局部区域标准方差通常作为客观评价参数衡量图像清晰程度, 该参数能够描述图像区域中灰度变化的强度。 一般情况下, 图像中灰度变换相对明显的区域也能集中体现特征, 所以借助局部区域标准方差的上述特性能够提取出图像中的特征。 因此, 采用局部区域标准方差作为低频系数融合规则。 该规则具体描述如下:

计算低频子带系数

采用式(12)和式(13)以选择融合后的低频系数。 融合规则如式(15)所示, 其中c=1.5代表阈值, 通过经营选择, 范围在0.1~0.3之间。

严格执行上述过程就计算得到融合后的低频系数FL, F。

饱和度通道图像的退化模型与雾霾天气下退化图像模型的形式一致

其中, A表示光源照射强度; S表示雾天的饱和度通道图像; S0表示无雾的饱和度通道图像; t(x)表示透射率(传输图或介质传输图), 它随着图像传感器与场景之间的距离呈指数衰减。

He等[5]在统计大量图像特征的基础上, 提出了暗通道的概念, 即无雾图像非天空部分的局部区域中, 至少有一个颜色通道亮度值是很低的, 甚至趋近于零

其中, Jc(y)为图像J(y)的R, G, B三通道中的某一个; Ω (x)代表以像素点x为中心的邻域。

由暗原色先验可以得到透射率t(x)

其中, 光源照射强度取各颜色通道的暗通道中亮度值最高的值

将估计得到的透射率和背景光带入式(28), 得到复原的饱和度通道图像

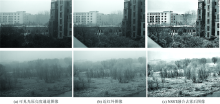

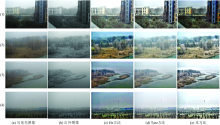

为了验证新算法的有效性, 特选取四组雾天条件下拍摄的真实近红外图像与可见光图像进行融合去雾处理, 将融合结果与He和Tarel方法对彩色可见光图像的去雾效果进行比较。

图5为4组图像经过He方法、 Tarel方法[14]和本方法处理后的结果。 图5(a)为彩色可见光图像, 呈现场景模糊、 边缘模糊不清、 图像对比度低的降质现象; 图5(b)为近红外图像, 对于近处的场景能够在一定程度上穿透雾霾, 捕获到较清晰的边缘细节信息; 图5(c)为He方法去雾后的结果, 处理后的图像较清晰, 边缘细节较清楚, 颜色校正获得的视觉效果好, 但是部分去雾出现方块效应; 图5(d)为Tarel方法处理的结果, 其图像的清晰度、 对比度和细节的表达在三种方法里相对较差, 而且颜色过校正, 呈现白色调; 图5(e)为本方法的去雾效果, 在三种方法中表现总体是最好的, 图像的对比度有显著提升, 边缘清晰, 颜色饱满, 视觉效果较理想。

对于雾霾图像的去雾处理的评价, 当前尚无统一的客观评价标准。 从平均梯度、 互信息量和边缘信息评价因子三个方法进行客观评价, 平均梯度AvG用来衡量微小细节的表述能力; 互信息量MI用来衡量结果图像从源图像中提取到的信息量, 这里计算的是从可见光图像中提取到的信息的多少; 边缘信息评价因子QAB/F用来衡量图像从源图像中提取到多少边缘信息量, 这里计算的是从可见光图像中提取到的边缘信息量的多少。 表1— 表4对应图5中4组图像采用三种方法处理结果的客观评价数据。

| 表1 图5(1)中融合结果的客观评价指标 Table 1 Objective evaluation index of fusion results in Fig.5(1) |

| 表2 图5(2)中融合结果的量化比较 Table 2 Objective evaluation index of fusion results in Fig.5(2) |

| 表3 图5(3)中融合结果的客观评价指标 Table 3 Objective evaluation index of fusion results in Fig.5(3) |

| 表4 图5(4)中融合结果的客观评价指标 Table 4 Objective evaluation index of fusion results in Fig.5(4) |

根据对客观指标的综合比较显示: 本方法在AvG参数上数值最大, 表明本方法对于图像细节的处理效果好, 对图像的边缘细节有很好地体现; 在互信息MI和边缘信息评价因子QAB/F方面, 本方法的值是最小的, 代表本方法从彩色可见光图像中提取的信息量和边缘信息量是最小的, 视觉效果是最好的, 这是因为其一可见光图像中不仅有有用信息, 还有雾霾噪声, 证明本方法的去雾效果较好; 其二, 虽然本方法从可见光图像中获取的信息量小, 但是本方法还通过NSST域的融合将近红外图像中的信息提取到了去雾后的图像中, 所以本算法的结果图像信息丰富、 图像边缘清楚、 图像对比度高, 在三种方法中的效果是最好的。

综上所述, 本方法将可见光和近红外图像进行融合去雾处理, 能够在图像的信息量、 对比度和边缘信息的表达能力方面得到很好的效果。

提出一种基于近红外与可见光双目图像传感器的融合去雾算法。 借助近红外传感器能够在雾天捕获可见光传感器无法捕获的图像细节, 将近红外图像与可见光图像进行融合, 在去雾的同时, 可以将近红外图像中的原始清晰细节提取融合到彩色可见光图像中, 得到边缘、 轮廓等特征量更加丰富的去雾图像。 实验结果表明, 本方法得到的图像在边缘信息、 对比度和信息量上具有很好的表述能力。 本算法将近红外传感器图像作为新的数据源, 近红外传感器能够在一定程度上穿透雾霾, 能够在雾天捕获可见光传感器无法捕获的图像细节, 而且硬件实现简单, 之后采用图像融合方法进行图像去雾, 为图像去雾提供了新的技术途径和路线。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|